Механизмы трансформации диванов — статьи про мебель на Викидивании

Откроем секрет: нет «плохих» и «хороших» механизмов трансформации, бывает неправильный подход к выбору подходящей модели. Разобраться в том, какие бывают диваны, найти «свой» вариант поможет обзор с короткими иллюстрирующими видео.

Подбирая тип трансформации, обращайте внимание на то, как раскладывается диван, легкость и скорость, соприкосновение с полом и наличие бельевого ящика. Важно и назначение будущего дивана – ежедневное использование или раскладывание от случая к случаю?

Книжка

Механизм, знакомый многим с детства. Трансформация из дивана в кровать проста и интуитивно понятна. Проверенные временем раскладные диваны оснащены вместительным бельевым отсеком под сиденьем и имеют привлекательную цену за счет простоты и неприхотливости конструкции.

Как разложить: сиденье поднимается вверх до щелчка, а затем опускается.

Чем хорош: низкой ценой, быстрым способом раскладывания, вместительным ящиком для белья.

О чем следует помнить: расстояние от спинки до стены должно быть не менее 10 см., для раскладывания необходимо приложить усилия.

Еврокнижка

Надежный и простой в использовании механизм трансформации дивана. Благодаря отсутствию петель на стыке спальная поверхность получается ровной и удобной. Спальное место располагается вдоль дивана, что идеально для узких помещений. Не нужно задумываться, как разложить или сложить «еврокнижку» и нет необходимости отодвигать каждый раз от стены – конструкция модели выдвигается вперед.

Как разложить: Выкатите сиденье и опустите спинку – место для отдыха готово.

Чем хорош: надежностью и вместительным ящиком для белья, нет необходимости двигать диван каждый раз при раскладывании, подходит для узких комнат.

О чем следует помнить: модели без колес могут царапать пол.

Пантограф

Данная разновидность имеет все преимущества «еврокнижки», и даже больше. Поднимающиеся диваны не оснащены роликами и раздвигаются не касаясь пола. Подъемный механизм выталкивает сиденье вверх и оно словно шагает вперед, оставляя напольное покрытие нетронутым. Обратный механизм складывания также не требует усилий.

Как разложить: потяните вверх и на себя сиденье и опустите спинку.

Чем хорош: не взаимодействует с полом, оснащен бельевым отсеком, не нужно двигать при раскладывании.

О чем следует помнить: для раскладывания требуется приложить больше усилий, чем в «еврокнижке».

Еврософа

Системы раскладывания на металлическом каркасе отличаются наждежностью и прочностью. Отлично подходят для активной ежедневной эксплуатации, с легкостью перенесут перестановки и переезды.

Как разложить: надавите сверху вниз на край спинки – плавно опускаясь, она займет горизонтальное положение. Для обратной трансформации потяните раму спинки вверх.

Чем хорош: имеет в основании металлический каркас, не требует отодвигания дивана от стены.

О чем следует помнить: единственный недостаток таких систем — относительно высокая стоимость.

Дельфин

Диван, в составе которого находится механизм «дельфин», раскладывается с особой легкостью и скоростью. Устройство получило название в честь одноименного животного благодаря схожести движений.

Как правило, встречается в угловых диванах. Каркас спального места удерживается за счет специальных кронштейнов на уровне основной части дивана. Благодаря компактности такая модель удачно впишется в интерьер небольшой комнаты, а вместительный ящик для белья под угловой частью поможет спрятать домашний текстиль и бытовую мелочь.

Как разложить: выдвините из-под сиденья раму и потяните вверх.

Пума

Подобно кошачьей поступи, диваны с механизмом «пума» раскладываются максимально тихо и аккуратно. Никаких царапин от ножек или промятых дорожек от колесиков – даже самое требовательное напольное покрытие не пострадает при ежедневном раскладывания. При трансформации нужны минимальные усилия: немного потяните сиденье вверх, а дальше всю работу сделает механизм.

Как разложить: потяните спальное место на себя за сиденье, а следом за ним появится часть, расположенная внизу.

О чем следует помнить: у прямых моделей нет ящика для белья. У угловых моделей он находится за оттоманкой.

Аккордеон

Механизм «аккордеон» получил свое название благодаря сходству раскладывания с движением мехов музыкального инструмента. Спальное место получается ровным и широким, без ощутимых стыков. Модель относится к категории раздвижных диванов и ощутимо съедает пространство в длину, выбирайте ее если пространство позволяет подобный простор для манипуляций.

Спальное место получается ровным и широким, без ощутимых стыков. Модель относится к категории раздвижных диванов и ощутимо съедает пространство в длину, выбирайте ее если пространство позволяет подобный простор для манипуляций.

Как разложить: потяните петлю и сиденье поедет вперед, а спинка развернется и разложится на две части.

Чем хорош: легкостью раскладывания.

О чем следует помнить: требует много места для раскладывания, поэтому не ставьте перед сиденьем столик или другую мебель. За механизмом нужно ухаживать и регулярно смазывать.

Караван

Механизм раскладывания на металлокаркасе, надежный и долговечный. За счет трансформации вперед организует широкое спальное место (аналог двуспальной кровати) при сравнительно небольших размерах дивана «караван».

Как разложить: потяните сиденье вверх – оно начнет описывать в воздухе дугу. В это же время из-под основания друг за другом появятся две дополнительные платформы. Когда сиденье опуститься на опоры, три функциональные части образуют ровную поверхность для сна.

В это же время из-под основания друг за другом появятся две дополнительные платформы. Когда сиденье опуститься на опоры, три функциональные части образуют ровную поверхность для сна.

Чем хорош: надежностью конструкции и простотой трансформации.

О чем следует помнить: так как место под сиденьем «каравана» занято дополнительными платформами, у диванов данного типа нет бельевого ящика.

Французская раскладушка

Французская раскладушка или «седафлекс» – легкое и компактное европейское гостевое решение. Из-за особенностей конструкции модель раскладывается значительно дольше «пумы» или «еврокнижки», в ней нет бельевого ящика, а также такой диван не подходит для ежедневного раскладывания. Если вам требуется вариант для частого использования, ищите модель французской раскладушки, где в поддерживающем основании вместо ткани деревянный каркас – этот вариант более полезен для позвоночника.

Как разложить: поднимите верхнюю подушку-сиденье и потяните за ножки вперед – спальное место, сложенное гармошкой, скрывается под сиденьем.

Чем хорош: легкостью и прочностью конструкции.

О чем следует помнить: нет ящика для белья, слишком мягкая постель (не рекомендуется для ежедневного сна), диваны с раскладывающимся вперед механизмом не всегда удачно вписываются в узкие помещения.

Рич

Механизм «Рич» или «Спартак» – американская раскладушка двойного сложения. В его конструкции – металлическая рама и сварная решетка, надежная и долговечная. Система подходит как для гостевого, так и для ежедневного использования. Главная особенность механизма – возможность «убирать» сиденье под спальное место, что автоматически облегчает задачу трансформации.

Как разложить: поднимите сиденье и потяните систему на себя – спальное место, сложенное вдвое, появится из-под основания.

Чем хорош: легко раскладывается, надежен и долговечен.

О чем следует помнить: в конструкции не предусмотрена бельевица.

Все категории и типы диванов имеют существенные и принципиальные различия. Отнеситесь к выбору модели с особой внимательностью и наслаждайтесь комфортом каждый день.

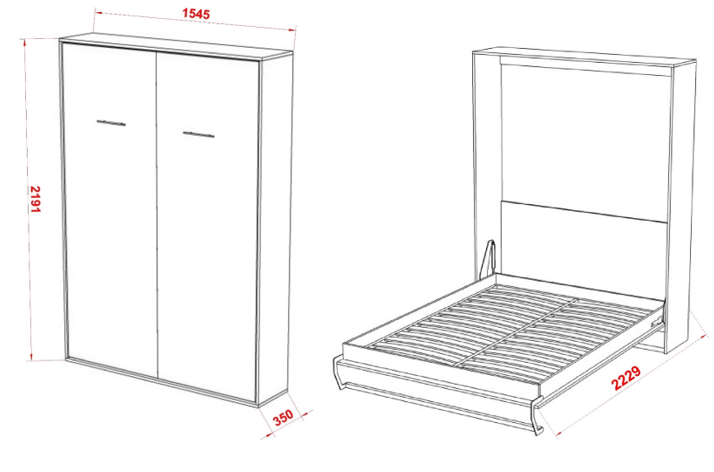

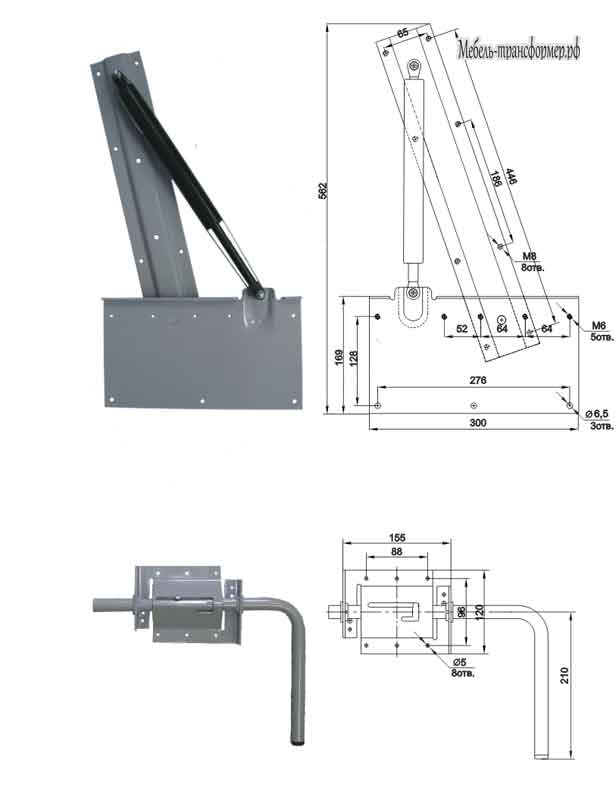

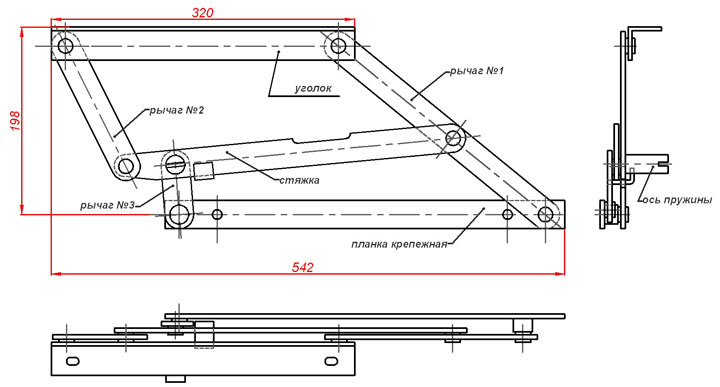

Механизм трансформации откидных (подъёмных) кроватей

Главная » Механизм трансформации откидных (подъёмных) кроватейпозволяет нам давать беспрецедентную гарантию — 100 лет

Срок эксплуатации пружинных механизмов или креплений газомаслянных амортизаторов через металлическую пластину к ЛДСП на саморезах/болтах, которые применяются в изделиях другого ценового диапазона, существенно ниже и, в среднем, не превышает 5 лет

Особенности подъемного механизма

Подъемные механизмы применяются в интерьере гораздо чаще, чем может показаться на первый взгляд. Ведь многие люди сталкиваются с проблемой нехватки пространства для реализации всех дизайнерских задумок. А раскладные кровати, которые выполняют разные функции в двух положениях, помогают выйти из многих ситуаций. В сложенном виде конструкция выступает в роли шкафа с отдельными полочками, а в разложенном – местом для отдыха. Главной особенностью производимых нами механизмов являются прочность и надежность, достигаемая за счет применения металлического каркаса, который значительно увеличивает срок эксплуатации мебели.

Ведь многие люди сталкиваются с проблемой нехватки пространства для реализации всех дизайнерских задумок. А раскладные кровати, которые выполняют разные функции в двух положениях, помогают выйти из многих ситуаций. В сложенном виде конструкция выступает в роли шкафа с отдельными полочками, а в разложенном – местом для отдыха. Главной особенностью производимых нами механизмов являются прочность и надежность, достигаемая за счет применения металлического каркаса, который значительно увеличивает срок эксплуатации мебели.

Видео-канал «Подъемные механизмы нашей мебели-трансформер»

Фабрика мебели «МеТра» создала свой видео-канал, главная задача которого – помочь понять все особенности и свойства подъемных механизмов, а также научится их правильно выбирать. Перейдя по ссылке, вы найдете несколько видео, которые посвящены разным мебельным темам. Однако мы уверены, что после детального ознакомления с ними, вы будете осведомлены во всех нюансах и деталях данных механизмов.

Однако мы уверены, что после детального ознакомления с ними, вы будете осведомлены во всех нюансах и деталях данных механизмов.

Будем рады помочь своими видео вам в выборе мебели, которая будет гармонично дополнять ваш интерьер и выступать в роли практичного и универсального предмета, который на 100% справляется со своими функциями.

Хотите узнать цену, звоните или заполняйте форму обратной связи на сайте!

+ 7 (495) 743-98-68

+ 7 (925) 110-98-68

Лучшая мебель-трансформер в Москве недорого, цены в каталоге на сайте компании Мебельная Эволюция

К нам обращаются за покупкой именно те люди, которые ценят свое время и предпочитают для себя в мебели лучшие решения по части:

— комфорта,

— качества исполнения,

— травмобезопасности (да-да, именно так! Позвоните нам, и мы расскажем об этих нюансах),

— отношения компании к клиенту на всех этапах взаимодействия, включая годы после покупки.

Мы делаем проекты различного уровня сложности и с разными дизайнерскими решениями: от строгого современного минимализма до классики, с карнизами, фрезеровками и врезными ручками.

С учетом того, что рынок кроватей-трансформеров в Москве достаточно молодой, наша компания является на нем одной из старейших. Мы активно работаем с 2015 года и реализовали свыше 500 проектов.

Поэтому к нам также приходят и люди, которые уже получили горький опыт общения с молодыми компаниями. Сейчас на рынке появилось много таких, которые ловко заманивают людей огромными скидками и якобы низкими ценами. Сначала они рассказывают басни, что сделают вам «все небо в алмазах», а потом делают или «как получится», или же, потратив кучу вашего времени на проработку проекта, вообще отказываются от его исполнения без какой-либо разумной аргументации.

Наше ценообразование простое и прозрачное. У нас нет каких-либо скрытых платежей и многократных наворотов на указанную на сайте цену.

У нас нет каких-либо скрытых платежей и многократных наворотов на указанную на сайте цену.

Накопленный за годы работы с трансформацией опыт позволил нам разработать собственный, уникальный механизм для откидных кроватей, благодаря которым наши кровати-трансформеры являются самыми удобными, самыми легкими при открывании и закрывании (при любом самом большом размере спального места или весе матраса!!!) и самыми травмобезопасными на отечественном рынке.

Являются ли наша мебель дешевой? Конечно, нет. Качественно изготовленная мебель, со всевозможными закруглениями и вырезами под плинтусы, толстыми ПВХ-кромками и защитными пленками на зеркалах, качественной европейской фурнитурой с доводчиками, в принципе не может стоить дешево. К тому же она выпускается в штучных или даже единичных количествах. Но мы стараемся работать так, чтобы наши цены «не зашкаливали» по рынку.

Поэтому, если Вам хочется иметь дома не просто мебель с трансформацией, а ее лучшее исполнение, и при этом Вы хотите быть уверены в том, что у Вас не будет каких-либо заморочек с компанией-производителем, добро пожаловать к нам!

С удовольствием сделаем Ваш дом просторным, стильным и уютным!

Механизмы диванов — Обзор видов и типов механизмов трансформации диванов

Диваны стали действительно незаменимой мебелью в наших домах. Они не только обеспечивают уютное место для отдыха в кругу семьи, но и представляют собой в разложенном виде полноценное спальное место. Чтобы трансформировать диван было как можно проще, конструкторы мебели разработали специальные механизмы. Они отличаются как по способу раскладывания, так и по другим характеристикам: удобству для ежедневного сна, занимаемой площади в собранном и разобранном виде и прочим.

Какие механизмы диванов бывают? Чем они отличаются между собой? Какой механизм дивана лучше для сна? Разберемся вместе.

Механизмы диванов по типу трансформации

Существуют следующие механизмы раскладывания:

- американская раскладушка;

- аккордеон;

- бриз;

- еврокнижка;

- клик-кляк;

- еврософа;

- танго;

- сезам;

- юниор;

Рассмотрим подробнее данные типы раскладывания диванов.

Американская раскладушка

Очень простой в обращении механизм, разложить такой диван сможет даже школьник. Необходимо потянуть спинку на себя ー спальное место своеобразным образом свернуто внутри. При небольшом усилии оно развернется ー сначала ножками вверх, его необходимо раскатать дальше ー и соберется в полноценную кровать.

Еще одно ценное преимущество такого механизма, помимо легкого раскладывания, заключается в удобстве спального места. Оно не имеет швов или стыков элементов дивана, характерных для других видов трансформации. Вы спите на полноценном матрасе.

Вы спите на полноценном матрасе.

Этот вид трансформации подойдет как для ежедневного сна одного или двух человек, так и для использования такого дивана в качестве гостевого. Мебель «американская раскладушка» очень компактна ー органично впишется даже в небольшое пространство гостиной.

Аккордеон

Ставший уже классическим для наших квартир механизм «аккордеон» по праву заслуживает своей славы. Это действительно простой и удобный в эксплуатации тип раскладывания.

Диван складывается в виде гармошки, состоящей из 3 частей: сиденья, передней и задней части спинки. В разложенном виде они становятся соответственно изножьем, средней частью спального места и изголовьем.

Особенностью этого типа является то, что при раскладывании образуется действительно просторное спальное место. На таком диване могут спокойно спать 2 взрослых и 1 ребенок! Стыки в элементах подогнаны достаточно плотно ー они практически не ощущаются.

В сложенном виде диван-аккордеон компактен, а вот в разложенном потребует много места. Обеспечьте примерно 2 на 1,5-2 метра площади перед ним.

Бриз

Удобный в использовании механизм, суть которого состоит в выкатывании части спального места вперед. Трансформация достаточно простая ー легко производится одной рукой. Не требует отодвигания дивана от стены и не занимает много места при раскладывании.

Спальное место получается вместительным, могут спать 2 взрослых человека. Однако для ежедневного сна может быть не очень удобным, так как механизм бриз предполагает несколько продольных и поперечных стыков.

Диван с подобным типом трансформации отлично подойдет для гостиной в качестве мебели для отдыха и дополнительного спального места.

Еврокнижка

Диван с этим механизмом не нужно отодвигать от стены, чтобы разложить. Его трансформация проводится в 2 действия ー сначала передняя часть выкатывается вперед, а затем в образовавшееся пространство укладывается спинка.

Спальное место имеет только 1 стык, что делает его крайне удобным для ежедневного сна. На диване в разложенном виде могут спать 2 взрослых человека ー он достаточно просторный. Другие преимущества этой модели:

- на сложенном диване 1 человек может лечь в полный рост;

- занимает мало места при раскладывании.

У диванов с подобным механизмом достаточно большая длина в сложенном состоянии, из-за чего они могут быть неуместны в малогабаритных квартирах. Зато даже в сложенном виде на таком диване уместится вся семья для отдыха перед телевизором.

Клик-кляк

Этот механизм предполагает раскладывание дивана по типу книжки. Производится в 2 действия ー сначала сиденья надо слегка приподнять, а затем опустить ー спинка также примет горизонтальное положение. Обратите внимание, что в процессе трансформации потребуется немного места у стены.

В разложенном виде представляет собой полноценное спальное место для 2 человек. Нет стыков или перепадов высоты, что делает клик-кляк одним из самых удобных механизмов для полноценного сна на каждый день.

Нет стыков или перепадов высоты, что делает клик-кляк одним из самых удобных механизмов для полноценного сна на каждый день.

Стоит также отметить, что диваны с таким механизмом оборудованы вместительными ящиками для белья.

Еврософа

Интересный по своему исполнению механизм трансформации, заключающийся в 2 действиях:

- выдвигается ящик для белья;

- на него как на опору раскладывается половинка сиденья.

Модели с таким механизмом раскладывания компактны в сложенном виде, занимают немного полезной площади комнаты. Спать на них очень удобно ー стык двух половинок практически не ощущается, а материал сидений упругий и в меру жесткий.

Танго

Этот механизм схож с системой трансформации клик-кляк. Для того чтобы из дивана сделать спальное место, сиденье надо приподнять вверх до определенной точки, а затем опустить. Спинка опустится одновременно с сиденьем, образуя ровное пространство для сна или отдыха. Отличие механизма танго ー в растровых подлокотниках, которые можно поднять под нужным вам углом. Во время сна можно сделать удобный подголовник.

Отличие механизма танго ー в растровых подлокотниках, которые можно поднять под нужным вам углом. Во время сна можно сделать удобный подголовник.

Такие диваны подходят для сна вдвоем, их часто покупают в детскую комнату. Обратите внимание ー для них понадобится чуть больше места, чем, к примеру, для мебели с системой трансформации аккордеон.

Сезам

Этот механизм ー авторская разработка специалистов фабрики ANDERSSEN и компании Steelglass. Он создан в соответствии с запросами клиентов на удобный и многофункциональный диван для гостиной или детской. Суть механизма в том, что он раскладывается в односпальную кровать с удобным матрасом, уложенным на ортопедические латы. Трансформация проводится в 2 действия:

- выдвигается за низ спрятанная в глубине кушетки секция;

- поднимается спальное место с высоким изголовьем.

Эту систему уже оценили наши покупатели ー диваны с механизмом сезам активно заказывают для детской или комнаты подростка. Вариант также удобен в качестве дополнительного места в случае ночевки гостя.

Вариант также удобен в качестве дополнительного места в случае ночевки гостя.

Юниор

Это идеальное решение для детской комнаты малой площади. В собранном виде мебель с таким механизмом представляет собой обычный диван. В разобранном ー 2 односпальные кровати, отделенные друг от друга мягкой секцией. Трансформация осуществляется очень легко ー достаточно вытянуть за петлю сиденье, а затем опустить спинку на место изголовья.

Кровати подходят для ежедневного сна, так как не имеют перепадов высоты и характеризуются умеренной жесткостью. Это замечательный выбор для спальни подросших детей или для гостиной в качестве дополнительных спальных мест.

Виды механизмов в зависимости от конструкции диванов

На сегодняшний день на рынке мягкой мебели представлены диваны различных конструкций с характерными для них типами раскладывания. Рассмотрим наиболее популярные из них:

- прямые модели ー обычно они имеют механизмы трансформации еврокнижка, клик-кляк, аккордеон, американская раскладушка, танго и другие.

Такие диваны компактны в сложенном виде и достаточно вместительны в разложенном;

Такие диваны компактны в сложенном виде и достаточно вместительны в разложенном; - угловые диваны обычно оснащаются такими механизмами трансформации как аккордеон, бриз, американская раскладушка, нью-роллер и еврософа. Они удобны для отдыха всей семьей перед телевизором, но занимают больше площади комнаты, чем прямые модели;

- кресла-кровати образуют полноценные спальные места для 1 человека благодаря механизмам трансформации аккордеон, нью-роллер или юниор. Отличное решение проблемы дополнительного спального места в небольших помещениях;

- кушетки представляют собой диваны, которые можно трансформировать в спальное место для 1 человека. Идеально подходят для детских комнат или малогабаритных квартир.

Лучшие механизмы диванов для сна и отдыха

Если диван будет вами использоваться и в качестве места для ежедневного сна, подойти к его выбору надо ответственно. Ведь он должен отвечать не только эстетическим, но и некоторым другим требованиям, например, иметь ортопедическое основание, при раскладывании образовывать минимум стыков и прочее.

Какой механизм дивана лучше для ежедневного сна? Мы подготовили топ-6 видов трансформации, которые идеально подойдут для полноценного отдыха:

- Американская раскладушка. Идеален для сна за счет спального места без стыков и удобного основания кровати.

- Еврософа. Удобный механизм трансформации, обеспечивающий вместительное спальное место. Получается поверхность только с 1 стыком, который не ощущается в процессе сна. Хороший вариант для основного варианта спального места.

- Клик-кляк. Простой в раскладывании механизм. Стыков в разложенном виде у таких диванов нет, что крайне удобно для сна каждую ночь. Единственный нюанс ー кого-то может смутить отсутствие бортика в изголовье.

Выбор механизма трансформации дивана в зависимости от потребности

Если вы ищете диван, который в разобранном виде был бы очень просторным, советуем обратить внимание на следующие виды трансформации:

Если вам нужен как можно более компактный вариант мебели, купите его с одним из таких видов раскладывания как:

Наиболее удобные диваны для детской ー это:

- юниор;

- сезам;

- кушетка.

Какой бы диван фирмы ANDERSSEN вы ни выбрали, будьте уверены ー он прослужит вам много лет, оставаясь таким же удобным и привлекательным с виду. Мебель нашей фабрики создает в доме уют и тепло.

Механизм для стола трансформера с защитным покрытием

Механизм для стола трансформера: использование и преимущества

Тенденция на использование в интерьере функциональной мебели по-прежнему находит отражение в обустройстве домов и квартир. Чаще всего для создания такой мебели используются механизмы трансформеры.

Использование механизмов

Желаете сэкономить пространство квартиры и при этом обставить ее стильной и изящной мебелью? Предлагаем современное решение от компании Грек – механизм для стола трансформера по доступной цене. С ним из изящного журнального столика одним движением можно создать просторный обеденный стол. Чтобы узнать о товаре больше, звоните по тел.: (495) 773 41 03.

При постоянном использовании механизм для стола трансформера позволяет освободить квартиру от громоздкой и неудобной мебели. Одновременно механизм может использоваться в одном помещении как предмет для досуга и стол для приема гостей за обедом.

В основе механизма для стола трансформера лежат:

- высококачественные материалы на основе стали;

- надежное защитное покрытие;

- качественные конструктивные элементы, обеспечивающие стабильность работы и безотказность.

Особенно полезным установка механизма для стола трансформера будет тогда, когда пространство дома или квартиры не позволяет обставить ее всей необходимой мебелью.

Выгодное предложение от компании Грек

В ассортименте компании Грек представлены механизмы трансформации от ведущих производителей России и мира. Благодаря налаженной схеме прямых поставок с заводов-изготовителей мы можем предложить доступные цены и гарантию качества продукции.

В каталоге продукции вы найдете:

Для оптовых покупателей действует система скидок, предоставляется услуга бесплатной доставки.

Ассортимент товаров постоянно пополняется новой качественной продукцией.

У нас Вы можете приобрести качественные механизмы трансформации и другую мебельную фурнитуру по низким ценам. Узнать о наших скидках и условиях постоянного сотрудничества, задать вопрос об ассортименте

Вы можете по тел.: (495) 773 41 03.

А точно ли мебель трансформер безопасна? Статья от производителя мебели трансформер шкаф-диван кровать

В предыдущей статье «Варианты организации спального места в малогабаритной квартире» мы пришли к выводу, что оптимальным решением для обустройства места для полноценного, здорового сна в однокомнатной квартире или в квартире-студии, станет приобретение трансформируемой мебели. Речь шла о таких композициях, как шкаф-кровать, шкаф-диван-кровать, шкаф-кровать-стол.

Исходя из своего большого опыта, мы знаем, что у людей, впервые сталкивающихся с указанными трансформерами и увидевшими, как кровать с помощью механизма трансформации опускается или поднимается, как правило, возникают сомнения, касающиеся безопасности такой мебели. Пришло время их развеять!

От каких факторов зависит безопасность шкафа-кровати?

Для начала обозначим перечень факторов, определяющих безопасность трансформеров, к их числу относят:

- систему опускания и подъёма кровати;

- материалы;

- рамы механизма;

- квалификацию сборщиков;

- условия эксплуатации.

Система опускания и подъёма кровати

Это один из наиважнейших факторов, от которого напрямую зависит надежность, долговечность и, что не менее важно, безопасная эксплуатация шкафов-кроватей. Сердцем системы опускания и подъёма кровати являются газлифты, именно они берут на себя основной вес кровати и делают процесс трансформации лёгким и плавным Следует понимать, что шкафы-кровати спроектированы так, что в сложенном (вертикальном) состоянии кровати стоят за осью вращению газлифтов. То есть те самые газлифты, которые помогают плавно поднимать и опускать кровать, в закрытом состоянии надежно удерживают кровать в вертикальном положении, так как всё время давят на кровать в сторону закрытия. Это обстоятельство не позволяет кровати открываться самопроизвольно и создает необходимость в некотором усилии в самом начале процесса открытия кровати – необходимо преодолеть начальное сопротивление газлифта. Это сопротивление исчезает, как только крвоать выравнивается с осью вращения газлифтов.

Дополнительным уровнем защиты от опускания кровати может быть замок открытия механизма, его следует устанавливать в том случае, если трансформер приобретается в детскую комнату. Ведь тот факт, что трансформер надежно удерживается в вертикальном положении газлифтами не означает, что дети не захотят поиграть с механизмом трансформации. Замок открытия кровати надежно защищает детей от таких игр.

Материалы

Безусловно, долговечность, надёжность, а, соответственно, и безопасность обсуждаемых нами трансформеров во многом определяются материалами, из которых их производят. В данном контексте очень важен материал, используемый для изготовления корпуса шкафа-кровати. Мы настоятельно рекомендуем шкафы-кровати с корпусом из ЛДСП толщиной 25мм. Дело в том, что в процессе трансформации механизм оказывает значительное давление на боковины корпуса и если корпус сделан из тонкого ЛДСП, толщиной 16 мм, то через пару лет от постоянных нагрузок у конструкции шкафа-кровати может появиться люфт. Корпус толщиной 25 мм легко выдерживает нагрузки, создаваемые механизмом трансформера, за счет чего шкаф-кровать сможет прослужить много лет и в эксплуатации будет совершенно безопасна.

Рамы механизма

Если газлифты – это сердце механизма трансформации шкафа-кровати, то рамы – это тело механизма. Рамы в трансформере две – одна нижняя с ламелями (именно на неё кладётся матрас) и одна верхняя, к который пристыковывается нижняя рама при закрытии кровати.

Часто производителями шкафов-кроватей используются сборные рамы, они удобны для транспортировки, так как их легко можно уместить в коробке, но всегда есть риск, что со временем собранные элементы рамы могут разболтаться, что поставит под вопрос безопасность эксплуатации кровати. Мы настоятельно рекомендуем выбрать шкафы-кровати с цельносварными рамами, где все места стыков заранее надёжно сварены заводом-изготовителем. Такие рамы никогда не разболтаются и будут являться гарантом безопасности трансформера шкафа-кровати на долгие годы.

Установка трансформеров – прерогатива специалистов

Есть такая пословица: «Сапоги должен тачать сапожник, а пирожные печь – пирожник». С этой народной мудростью трудно не согласиться в принципе, а особенно применительно к установке шкафов-кроватей, требующих крепления к стене. Такие трансформеры требуют чёткого выполнения инструкции по креплению мебели к стене, так что мы рекомендуем привлекать к сборке специалистов, чтобы дальнейшая эксплуатация мебели была совершенно безопасна. В случае, если Вы заказываете трансформер в Москве или в Московской области, мы рекомендуем привлекать наших специалистов к сборке трансформеров. Если Вы проживаете в другом городе, то целесообразно привлечь организацию, специализирующуюся на сборке мебели.

Со шкафами-кроватями, не требующими крепления к стене, ситуация обстоит иначе. Их легко собрать по схеме, которая идёт в комплекте поставки вместе с мебелью. Так как механизмы наших трансформеров цельносварные, даже у неподготовленного человека обычно получается собрать нашу мебель легко и просто. А главное, если в процессе сборки отдельностоящего трансформера всё-таки будут допущены ошибки, они никак не скажутся на безопасности эксплуатации мебели.

Правила эксплуатации

Эксплуатация любой мебели, в том числе и шкафов-кроватей или шкафов-кроватей-диванов, предполагает соблюдения определённых правил, связанных с (со):

- аккуратным обращением;

- слежением за исправностью механизма подъёма;

- недопустимостью самостоятельных ремонтных работ;

- соблюдением рекомендаций производителя по матрасу: по его максимальным весу и размерам – это особенно актуально, если выбранная модель трансформера не оснащена матрасом, а потому его приходится покупать дополнительно.

Нельзя не упомянуть ещё одного значимого фактора безопасности трансформируемой мебели. Речь идёт о её производителях. Ведь именно от них зависят все остальные факторы: разработка безопасной конструкции, точное соблюдение производственных технологий, использование качественных, прочных материалов, закупка подъёмных механизмов и прочей фурнитуры у проверенных поставщиков.

Ателье умной мебели «Stylint»

К числу производителей трансформеров, продукцию которых вы можете приобретать без каких-либо опасений, без сомнения, относится наше Ателье умной мебели «Stylint» в Москве. Для изготовления шкафов-кроватей и прочей трансформирующейся мебели мы используем:

- металлические каркасы из высокопрочных стальных профильных труб, диаметр которых варьируется в диапазоне от 20 до 50 мм;

- надёжные цельносварные подъёмные механизмы от проверенных производителей, способных легко и бесшумно менять положение трансформеров;

- лёгкие, но очень прочные берёзовые ламели – надёжные опоры для матрасов, а, помимо этого, они усиливают ортопедический эффект матрасов;

Наши кровати, встраиваемые в шкафы, выдерживают нагрузку до 500 кг!

Мебель трансформер от ателье «Stylint» – это высокая надёжность, отменное качество, эстетичность и оригинальность внешнего вида, по-настоящему выгодные цены!

Механизмы трансформации

Диван с механизмом трансформации – уже давно не редкость. И это нисколько не удивительно, ведь, приобретая раскладной диван, вы вместе с тем приобретаете также и комфортабельное спальное место, которое можете спрятать в любой момент по своему желанию.

Что нужно знать при выборе такого дивана? Обычно, приобретая определенную модель, мы обращаем внимание на ее внешний вид: геометрию, цветовое решение, разнообразие декоративных элементов – однако не менее важный фактор – это наличие механизма трансформации. Механизм трансформации – это тот атрибут, который поможет вам легко и быстро превратить диван в комфортабельное спальное место. Устройство системы раскладывания дивана различается в зависимости от того, для какой конкретно модели оно предназначено. Так, например, механизмы для диван-кроватей работают совершенно иначе, чем системы для угловых диванов, а механизмы трансформации, спроектированные для ежедневного раскладывания, сильно отличаются от предназначенных для редкого использования.

Механизмы трансформации угловых диванов

Самые распространенные модели механизмов трансформации угловых диванов – это «Тик-так», иначе называемый «Пантографом», «Дельфин» и «Еврокнижка». Все три этих механизма похожи тем, что часть спального места формируется благодаря стационарной угловой части дивана, а другая часть выдвигается вперед посредством механизма. Такие конструкции не только просты в обращении, но еще и достаточно надежны. Вы непременно цените по достоинству практичность, эргономичность, функциональность этих механизмов, а также высокую продолжительность срока их службы.

Раскладушки

«Дионис» и «Спартак» — это одни из самых популярных моделей для диванов-раскладушек. Их главная особенность состоит в том, что широкий мягкий матрас встраивается в сам каркас дивана. Чтобы привести такой механизм в действие, вам понадобится убрать с дивана подушки, а затем потянуть на себя верхнюю половину механизма – и комфортабельная удобная кровать готова!

«Французская раскладушка» очень похожа принципом своей работы, однако ее главное отличие состоит в том, что она не предназначается для каждодневного использования. Однако если гости иногда задерживаются у вас на ночь и вам необходимо иметь возможность организовать дополнительное спальное место, то диван с таким механизмом – это наилучший вариант.

Диван-кровать

В разобранном состоянии она выглядит как самая обыкновенная широкая кровать, а в собранном представляет собой компактный аккуратный диван. В большинстве случаев в диван-кроватях используется механизм «Аккордеон». Стандартный диван-кровать представляет собой конструкцию из трех частей, одна из которых образует сидение дивана, а две другие – его спинку. Чтобы разложить такой диван, вам достаточно просто потянуть на себя его сидение. Пожалуй, это один из самых простых и в то же время надежных механизмов трансформации.

Интернет магазин «Русбелторг» предлагает вашему вниманию широкий выбор диванов с различными механизмами трансформации. Наши консультанты всегда рады помочь вам сделать правильный выбор, а на сайте вы найдете всю необходимую для вас информацию.

Мы приглашаем за покупками в наш интернет магазин!

Ниже представлены наиболее популярные на сегодняшний день механизмы трансформации диванов, которыми в большинстве случаев оборудуется мягкая мебель.

Еврокнижка

Характерной чертой механизма трансформации «Еврокнижка» является его надежность и вместе с тем простота использования. Основные преимущества этой системы – наличие в ней одинаковых мягких элементов, благодаря которым формируется безукоризненно ровное спальное место.

Аккордеон

Этот механизм трансформации поможет правильно распределить свободное пространство вашей комнаты. Он предоставит вам удобное широкое спальное место, достаточное минимум для двоих человек, а в сложенном виде диван с такой конструкцией станет изысканным и вместе с тем компактным украшением вашей комнаты.

Французская раскладушка

«Французская раскладушка» считается одним из самых практичных механизмов, а потому мягкая мебель, оснащенная ею, широко распространена не только в странах СНГ, но и во всем мире. Немаловажен и тот факт, что диван с «Французской раскладушкой» займет в вашей комнате куда меньше места, нежели любой другой диван.

Книжка

Этот механизм сочетает в себе простоту и многофункциональность. Как известно, все гениальное просто, и механизм трансформации «Книжка» настолько прост, что его попросту невозможно сломать. Другое свое название – «Клик-клак» – он получил благодаря щелкающему звуку, который производит во время трансформации.

Дельфин

Механизм «Дельфин» прост и удобен, а также практичен. Вы можете быть уверены в том, что диван, оснащенный такой системой раскладывания, прослужит вам в течение многих лет. Благодаря компактности габаритов, конструкция позволяет добавить вместительный бельевой ящик, в котором вы сможете хранить все спальные принадлежности.

Релакс

Этот инновационный механизм трансформации не имеет аналогов на территории других стран СНГ. «Релакс» применяется только для кресел, а его удобство и простота позволяют приводить его в движение, не вставая с места. «Релакс» обладает уникальной конструкцией, а также ортопедическими свойствами, то есть позволяет вашему телу принять максимально правильное положение и полностью расслабиться.

Тик-так (Пантограф)

Этот механизм был разработан сравнительно недавно, но и за достаточно короткое время успел завоевать внимание покупателей. Он отличается удобством в использовании, раскладывание его не требует особых усилий, а диван за считанные секунды превращается в просторное комфортабельное спальное место.

Вперед раскладной

Механизм трансформации «Вперед раскладной» по праву считается одним из самых долговечных и практичных из всех существующих на данный момент. Диван с такой системой раскладывания прекрасно подойдет для небольших городских квартир, где существует острая необходимость сэкономить свободное пространство, однако уместно будет смотреться и в достаточно просторной комнате.

Спартак

«Спартак» — пожалуй, износостойкий и долговечный механизм трансформации. Его каркас производится из прочных стальных труб, а сама конструкция рассчитана на ежедневное использование. Диван с механизмом «Спартак» прослужит вам в течение многих лет.

Седафлекс (Дионис)

Механизм трансформации «Дионис» («Седафлекс») является воплощением надежности и неприхотливости в использовании. Он отлично подходит как для элитной мягкой мебели, так и для диванов бюджетных вариантов. Именно поэтому «Дионис» так популярен среди производителей мебели. Он сочетает в себе износостойкость, прочность и компактность – диван с такой конструкцией будет смотреться аккуратно и изысканно и сможет предоставить вам удобное спальное место.

Механизм с электроприводом

Такая конструкция – это инновационный подход к решению конструирования механизмов трансформации. Всего одним нажатием кнопки вы легко разложите ваш диван, за считанные секунды организовав удобное комфортабельное спальное место минимум для двоих человек.

Выкатной механизм трансформации

Выкатные механизмы трансформации для диванов выгодно отличаются простотой и необычайной надежностью своей конструкции. Выкатные диваны достаточно часто встречаются в современных гостиных и стильных спальнях.

Телескоп

«Телескоп» является ярчайшим представителем компактных и удобных механизмов трансформации. Он позволяет облегчить конструкцию дивана и, как следствие, уменьшить его габариты. В процессе раскладывания сиденье дивана плавно выкатывается вперед, вытягивание же головной части конструкции механизма предоставляет вам широкое спальное место.

Трансформер

Механизм «Трансформер» обычно используется как вариант для гостевого дивана. Основание этого механизма эластичное – оно представляет собой полотнище из синтетических материалов, прикрепленное к раме при помощи проволоки и пружин. Такое основание поддерживается восьмью гнутоклеенными планками, а также кармашками из полимерных материалов. Максимальная нагрузка, которую выдерживает механизм, составляет 220 кг.

Металлокаркасный «Аккордеон»

Металлокаркасный «Аккордеон» обладает рядом характерных отличительных черт. Помимо простоты, удобства и надежности, этот механизм наделен ортопедическим эффектом, который поможет вашему телу расслабиться и принять правильное положение, обеспечит отдых мышцам и сформирует правильный кровоток. Диван с металлокаркасным «Аккордеоном» прослужит гораздо дольше обычной мебели, а также гарантирует необычайную легкость раскладывания и великолепный отдых.

Седалифт

Простая и удобная конструкция, такая, как «Седалифт», превосходно подойдет для ежедневного использования. Спальное место в таких диванах формируется благодаря сидению и матрасу, а сам механизм не требует много места.

Рибалто

Механизм трансформации «Рибалто» — это техническое решение и дизайн, которые обязательно порадуют вас своей красотой и легкостью. «Рибалто» обычно называют двускладным механизмом, поскольку раскладывается он в два счета.

Твин

Механизм «Твин» отмечен целым рядом достоинств, а в списке механизмов-трансформеров он, безусловно, занимает лидирующую позицию. В этой связи важно упомянуть, что механизм «Твин» имеет ортопедическое основание, что сделает ваш отдых просто безупречным. Он формирует широкую просторную кровать, которую вы в любой момент сможете трансформировать в удобный, красивый и эргономичный диван.

Вверх раскладной двухъярусный

Современный механизм-трансформер «Вверх раскладной двухъярусный» – это совершенно новый взгляд на все прежние механизмы трансформации. Этот способ раскладывания дивана позволит вам преобразовать мебель таким образом, что в итоге вы получите удобную двухъярусную кровать. Механизм «Вверх раскладной двухъярусный» экономит место в вашей комнате, а мебель, оснащенная такой системой раскладывания, является эргономичной даже в разобранном состоянии.

Растровый

Растровый механизм трансформации – это отличный вариант диван-кровати. Растровый диван выгодно отличается по своим свойствам от раскладных диван-кроватей иных конструкций. Трансформер, предназначенный для такого дивана, позволяет вам менять положение подлокотников и спинки по своему желанию.

Пума

Знакомьтесь — механизм трансформации «Пума». Надежный и прочный, он предназначен для ежедневного использования дивана в качестве кровати и является представителем нового, современного типа трансформеров.

The Illustrated Transformer — Джей Аламмар — Визуализация машинного обучения по одной концепции за раз.

Обсуждения:

Hacker News (65 баллов, 4 комментария), Reddit r / MachineLearning (29 баллов, 3 комментария)

Переводы: Испанский, Китайский (упрощенный), Корейский, Русский, Китайский (Упрощенный), Французский, Японский

Смотреть: лекция MIT по теме «Глубокое обучение» со ссылкой на эту публикацию

В предыдущем посте мы рассмотрели «Внимание» — повсеместный метод в современных моделях глубокого обучения.Внимание — это концепция, которая помогла повысить производительность приложений нейронного машинного перевода. В этом посте мы рассмотрим The Transformer — модель, которая привлекает внимание для повышения скорости обучения этих моделей. Трансформеры превосходят модель нейронного машинного перевода Google в определенных задачах. Однако самое большое преимущество заключается в том, что The Transformer поддается распараллеливанию. Фактически, Google Cloud рекомендует использовать The Transformer в качестве эталонной модели для использования своего предложения Cloud TPU.Итак, давайте попробуем разбить модель на части и посмотрим, как она работает.

Трансформатор был предложен в статье «Внимание — это все, что вам нужно». Его реализация в TensorFlow доступна как часть пакета Tensor2Tensor. Группа НЛП из Гарварда создала руководство с аннотациями к статье с использованием PyTorch. В этом посте мы попытаемся немного упростить вещи и представить концепции одну за другой, чтобы, надеюсь, облегчить понимание людям без глубоких знаний предмета.

2020 Обновление : Я создал видео «Рассказанный трансформер», в котором более мягкий подход к теме:

Взгляд высокого уровня

Давайте начнем с рассмотрения модели как единого черного ящика. В приложении машинного перевода оно берет предложение на одном языке и выводит его перевод на другом.

Раскрывая эту доброту Оптимуса Прайма, мы видим компонент кодирования, компонент декодирования и связи между ними.

Компонент кодирования представляет собой стек кодировщиков (на бумаге шесть из них складываются друг на друга — в цифре шесть нет ничего волшебного, можно определенно поэкспериментировать с другими компоновками). Компонент декодирования представляет собой стек декодеров с одинаковым числом.

Все кодировщики идентичны по структуре (но у них нет общих весов). Каждый из них разбит на два подслоя:

Входные данные кодировщика сначала проходят через слой самовнимания — слой, который помогает кодировщику смотреть на другие слова во входном предложении, когда он кодирует определенное слово.Позже мы подробнее рассмотрим самовнимание.

Выходные данные слоя самовнимания передаются в нейронную сеть с прямой связью. Точно такая же сеть прямой связи независимо применяется к каждой позиции.

У декодера есть оба этих уровня, но между ними есть уровень внимания, который помогает декодеру сосредоточиться на соответствующих частях входного предложения (аналогично тому, что делает внимание в моделях seq2seq).

Использование тензоров в картине

Теперь, когда мы рассмотрели основные компоненты модели, давайте приступим к рассмотрению различных векторов / тензоров и того, как они перемещаются между этими компонентами, чтобы превратить входные данные обученной модели в выходные данные.

Как и в случае с приложениями НЛП в целом, мы начинаем с превращения каждого входного слова в вектор с помощью алгоритма встраивания.

Каждое слово вложено в вектор размером 512. Мы представим эти векторы этими простыми прямоугольниками.

Встраивание происходит только в самый нижний кодировщик. Абстракция, которая является общей для всех кодировщиков, заключается в том, что они получают список векторов, каждый из которых имеет размер 512. В нижнем кодировщике это будет слово embeddings, но в других кодировщиках это будет выход кодировщика, который находится непосредственно под .Размер этого списка — это гиперпараметр, который мы можем установить — в основном это будет длина самого длинного предложения в нашем наборе обучающих данных.

После встраивания слов в нашу входную последовательность каждое из них проходит через каждый из двух уровней кодировщика.

Здесь мы начинаем видеть одно ключевое свойство преобразователя, а именно то, что слово в каждой позиции проходит свой собственный путь в кодировщике. Между этими путями на уровне самовнимания есть зависимости.Однако уровень прямой связи не имеет этих зависимостей, и, таким образом, различные пути могут выполняться параллельно при прохождении через слой прямой связи.

Затем мы заменим пример более коротким предложением и посмотрим, что происходит на каждом подуровне кодировщика.

Теперь мы кодируем!

Как мы уже упоминали, кодировщик получает в качестве входных данных список векторов. Он обрабатывает этот список, передавая эти векторы в слой «самовнимания», затем в нейронную сеть с прямой связью, а затем отправляет выходные данные вверх следующему кодировщику.

Слово в каждой позиции проходит процесс самовнимания. Затем каждый из них проходит через нейронную сеть с прямой связью — точно такую же сеть, и каждый вектор проходит через нее отдельно.

Самовнимание на высоком уровне

Не дайте себя обмануть, если я использую слово «самовнимание», как будто это понятие должно быть знакомо каждому. Я лично никогда не сталкивался с этой концепцией до тех пор, пока не прочитал статью «Все, что вам нужно». Давайте разберемся, как это работает.

Скажем, следующее предложение является вводным предложением, которое мы хотим перевести:

” Животное не переходило улицу, потому что оно слишком устало ”

Что означает «оно» в этом предложении? Относится ли это к улице или к животному? Это простой вопрос для человека, но не такой простой для алгоритма.

Когда модель обрабатывает слово «оно», самовнимание позволяет ей ассоциировать «это» с «животным».

По мере того, как модель обрабатывает каждое слово (каждую позицию во входной последовательности), самовнимание позволяет ей смотреть на другие позиции во входной последовательности в поисках подсказок, которые могут помочь улучшить кодирование этого слова.

Если вы знакомы с RNN, подумайте, как поддержание скрытого состояния позволяет RNN включать свое представление предыдущих слов / векторов, которые она обработала, с текущим, который она обрабатывает. Самовнимание — это метод, который Трансформер использует для «запекания» других релевантных слов в словах, которые мы обрабатываем в данный момент.

Поскольку мы кодируем слово «оно» в кодировщике №5 (верхний кодировщик в стеке), часть механизма внимания фокусировалась на «Животном» и запекла часть его представления в кодировке «оно».

Обязательно ознакомьтесь с записной книжкой Tensor2Tensor, где вы можете загрузить модель Transformer и изучить ее с помощью этой интерактивной визуализации.

Внимание к себе в деталях

Давайте сначала посмотрим, как вычислить самовнимание с помощью векторов, а затем перейдем к тому, как это на самом деле реализовано — с помощью матриц.

Первый шаг в вычислении самовнимания состоит в том, чтобы создать три вектора из каждого из входных векторов кодировщика (в данном случае — вложение каждого слова).Итак, для каждого слова мы создаем вектор запроса, вектор ключа и вектор значения. Эти векторы создаются путем умножения вложения на три матрицы, которые мы обучили в процессе обучения.

Обратите внимание, что эти новые векторы меньше по размерности, чем вектор внедрения. Их размерность составляет 64, в то время как векторы ввода / вывода встраивания и кодировщика имеют размерность 512. Они НЕ ДОЛЖНЫ быть меньше, это выбор архитектуры, позволяющий сделать вычисление многогранного внимания (в основном) постоянным.

Умножение x1 на весовую матрицу WQ дает q1, вектор «запроса», связанный с этим словом. В итоге мы создаем проекцию «запроса», «ключа» и «значения» для каждого слова во входном предложении.

Что такое векторы «запроса», «ключа» и «значения»?

Это абстракции, которые полезны для вычисления внимания и размышления о нем. После того, как вы перейдете к прочтению того, как рассчитывается внимание ниже, вы будете знать почти все, что вам нужно знать о роли каждого из этих векторов.

Второй шаг в вычислении самовнимания — это подсчет баллов. Предположим, мы рассчитываем самовнимание для первого слова в этом примере — «Мышление». Нам нужно сопоставить каждое слово входного предложения с этим словом. Оценка определяет, сколько внимания следует уделять другим частям входного предложения, когда мы кодируем слово в определенной позиции.

Оценка рассчитывается как скалярное произведение вектора запроса на ключевой вектор соответствующего слова, которое мы оцениваем.Итак, если мы обрабатываем самовнимание для слова в позиции №1, первая оценка будет скалярным произведением q1 и k1. Вторая оценка будет скалярным произведением q1 и k2.

Третий и четвертый этапы заключаются в разделении оценок на 8 (квадратный корень из размерности ключевых векторов, используемых в статье — 64. Это приводит к получению более стабильных градиентов. Здесь могут быть и другие возможные значения, но это значение по умолчанию), затем передайте результат через операцию softmax.Softmax нормализует оценки, чтобы все они были положительными и в сумме составляли 1.

.Эта оценка softmax определяет, насколько каждое слово будет выражено в этой позиции. Очевидно, что слово в этой позиции будет иметь самый высокий балл softmax, но иногда полезно обратить внимание на другое слово, имеющее отношение к текущему слову.

Пятый шаг — это умножение каждого вектора значений на оценку softmax (при подготовке к их суммированию). Интуиция здесь состоит в том, чтобы сохранить неизменными значения слов, на которых мы хотим сосредоточиться, и заглушить нерелевантные слова (умножив их на крошечные числа, такие как 0.001, например).

Шестой этап заключается в суммировании векторов взвешенных значений. Это производит вывод слоя самовнимания в этой позиции (для первого слова).

На этом расчет самовнимания завершен. Результирующий вектор — это тот, который мы можем отправить в нейронную сеть с прямой связью. Однако в реальной реализации этот расчет выполняется в матричной форме для более быстрой обработки. Итак, давайте посмотрим на это теперь, когда мы увидели интуицию вычисления на уровне слов.

Матрица расчета самовнимания

Первым шагом является вычисление матриц запроса, ключа и значения. Мы делаем это, упаковывая наши вложения в матрицу X и умножая ее на матрицы весов, которые мы обучили (WQ, WK, WV).

Каждая строка в матрице X соответствует слову во входном предложении. Мы снова видим разницу в размере вектора встраивания (512 или 4 прямоугольника на рисунке) и векторов q / k / v (64 или 3 прямоугольника на рисунке).

Наконец, , поскольку мы имеем дело с матрицами, мы можем сжать шаги со второго по шестой в одной формуле для вычисления выходных данных слоя самовнимания.

Расчет самовнимания в матричной форме

Многоголовый зверь

В статье дополнительно усовершенствован слой самовнимания, добавлен механизм, называемый «многоголовым» вниманием. Это улучшает производительность слоя внимания двумя способами:

Расширяет способность модели фокусироваться на разных позициях. Да, в приведенном выше примере z1 содержит немного любой другой кодировки, но в ней может преобладать само слово.Было бы полезно, если бы мы переводили предложение вроде «Животное не переходило улицу, потому что оно слишком устало», мы хотели бы знать, к какому слову «оно» относится.

Он дает слою внимания несколько «подпространств представления». Как мы увидим далее, с многоголовым вниманием у нас есть не только один, но и несколько наборов весовых матриц запроса / ключа / значения (преобразователь использует восемь головок внимания, поэтому мы получаем восемь наборов для каждого кодировщика / декодера). . Каждый из этих наборов инициализируется случайным образом.Затем, после обучения, каждый набор используется для проецирования входных вложений (или векторов из нижних кодеров / декодеров) в другое подпространство представления.

С многоголовым вниманием мы поддерживаем отдельные весовые матрицы Q / K / V для каждой головы, в результате чего получаются разные матрицы Q / K / V. Как и раньше, мы умножаем X на матрицы WQ / WK / WV, чтобы получить матрицы Q / K / V.

Если мы проделаем тот же расчет самовнимания, который мы описали выше, всего восемь раз с разными весовыми матрицами, мы получим восемь разных Z-матриц

Это оставляет нам небольшую проблему.Слой прямой связи не ожидает восьми матриц — он ожидает единственную матрицу (вектор для каждого слова). Итак, нам нужен способ сжать эти восемь в единую матрицу.

Как мы это делаем? Мы объединяем матрицы, а затем умножаем их на дополнительную матрицу весов WO.

Вот и все, что нужно для многоглавого самовнимания. Я понимаю, что это довольно много матриц. Позвольте мне попытаться объединить их все в один визуальный ряд, чтобы мы могли рассматривать их в одном месте

Теперь, когда мы коснулись головок внимания, давайте вернемся к нашему предыдущему примеру, чтобы увидеть, на чем фокусируются различные головы внимания, когда мы кодируем слово «оно» в нашем примере предложения:

Когда мы кодируем слово «оно», одна голова внимания больше всего сосредотачивается на «животном», в то время как другая фокусируется на «усталом» — в некотором смысле, представление модели слова «оно» вписывается в некоторые из представлений. как «животное», так и «уставшее».

Однако, если мы добавим все внимание к изображению, интерпретировать вещи будет сложнее:

Представление порядка последовательности с использованием позиционного кодирования

В модели, которую мы описали до сих пор, отсутствует одна вещь, так это способ учесть порядок слов во входной последовательности.

Для решения этой проблемы преобразователь добавляет вектор к каждому встраиванию входа. Эти векторы следуют определенному шаблону, который модель изучает, что помогает ей определять положение каждого слова или расстояние между разными словами в последовательности.Интуиция здесь заключается в том, что добавление этих значений к вложениям обеспечивает значимые расстояния между векторами встраивания, когда они проецируются в векторы Q / K / V и во время внимания скалярного произведения.

Чтобы дать модели ощущение порядка слов, мы добавляем векторы позиционного кодирования, значения которых следуют определенному шаблону.

Если мы предположим, что вложение имеет размерность 4, фактическое позиционное кодирование будет выглядеть так:

Реальный пример позиционного кодирования с размером вложения игрушки 4

Как мог бы выглядеть этот узор?

На следующем рисунке каждая строка соответствует позиционному кодированию вектора.Таким образом, первая строка будет вектором, который мы добавим к встраиванию первого слова во входной последовательности. Каждая строка содержит 512 значений — каждое от 1 до -1. Мы присвоили им цветовую кодировку, чтобы узор был виден.

Реальный пример позиционного кодирования для 20 слов (строк) с размером встраивания 512 (столбцов). Вы можете видеть, что он разделен пополам по центру. Это потому, что значения левой половины генерируются одной функцией (которая использует синус), а правая половина генерируется другой функцией (которая использует косинус).Затем они объединяются, чтобы сформировать каждый из векторов позиционного кодирования.

Формула позиционного кодирования описана в статье (раздел 3.5). Вы можете увидеть код для генерации позиционных кодировок в get_timing_signal_1d () . Это не единственный возможный метод позиционного кодирования. Однако это дает преимущество возможности масштабирования до невидимой длины последовательностей (например, если нашу обученную модель просят перевести предложение длиннее, чем любое из предложений в нашем обучающем наборе).

Июль 2020 Обновление: Позиционное кодирование, показанное выше, взято из реализации Transformer2Transformer. Метод, показанный в статье, немного отличается тем, что он не соединяет напрямую, а переплетает два сигнала. На следующем рисунке показано, как это выглядит. Вот код для его создания:

Остатки

Одна деталь в архитектуре кодера, которую мы должны упомянуть, прежде чем двигаться дальше, заключается в том, что каждый подуровень (самовнимание, ffnn) в каждом кодере имеет остаточное соединение вокруг себя, за которым следует этап нормализации уровня. .

Если мы визуализируем векторы и операцию уровня-нормы, связанную с самовниманием, это будет выглядеть так:

Это также относится к подуровням декодера. Если мы представим себе преобразователь из двух стековых кодировщиков и декодеров, он будет выглядеть примерно так:

Сторона декодера

Теперь, когда мы рассмотрели большинство концепций кодировщика, мы в основном знаем, как работают компоненты декодеров.Но давайте посмотрим, как они работают вместе.

Кодер запускает обработку входной последовательности. Затем выходной сигнал верхнего кодера преобразуется в набор векторов внимания K и V. Они должны использоваться каждым декодером на его уровне «внимание кодер-декодер», который помогает декодеру сосредоточиться на соответствующих местах во входной последовательности:

После завершения этапа кодирования мы начинаем этап декодирования. Каждый шаг в фазе декодирования выводит элемент из выходной последовательности (в данном случае предложение английского перевода).

Следующие шаги повторяют процесс до тех пор, пока не будет достигнут специальный символ, указывающий, что декодер трансформатора завершил свой вывод. Выходной сигнал каждого шага подается в нижний декодер на следующем временном шаге, и декодеры выводят свои результаты декодирования так же, как это сделали кодеры. И так же, как мы поступили с входами кодировщика, мы встраиваем и добавляем позиционное кодирование к этим входам декодера, чтобы указать положение каждого слова.

Слои самовнимания в декодере работают немного иначе, чем в кодировщике:

В декодере слой самовнимания может обращать внимание только на более ранние позиции в выходной последовательности.Это делается путем маскирования будущих позиций (установка для них значений -inf ) перед шагом softmax при вычислении самовнимания.

Слой «Внимание кодировщика-декодера» работает так же, как многоголовое самовнимание, за исключением того, что он создает свою матрицу запросов из слоя под ним и берет матрицу ключей и значений из выходных данных стека кодировщика.

Последний слой Linear и Softmax

Стек декодера выводит вектор чисел с плавающей запятой. Как превратить это в слово? Это работа последнего слоя Linear, за которым следует слой Softmax.

Линейный слой — это простая полносвязная нейронная сеть, которая проецирует вектор, созданный стеком декодеров, в гораздо более крупный вектор, называемый вектором логитов.

Предположим, что наша модель знает 10 000 уникальных английских слов («выходной словарь» нашей модели), которые она выучила из набора обучающих данных. Это сделало бы вектор логитов шириной 10 000 ячеек — каждая ячейка соответствует количеству уникального слова. Вот как мы интерпретируем вывод модели, за которой следует линейный слой.

Затем слой softmax превращает эти оценки в вероятности (все положительные, все в сумме дают 1,0). Выбирается ячейка с наибольшей вероятностью, и слово, связанное с ней, создается в качестве выходных данных для этого временного шага.

Этот рисунок начинается снизу с вектора, полученного на выходе стека декодера. Затем оно превращается в выходное слово.

Итоги обучения

Теперь, когда мы рассмотрели весь процесс прямого прохода через обученный преобразователь, было бы полезно взглянуть на интуицию обучения модели.

Во время обучения неподготовленная модель проделает точно такой же прямой проход. Но поскольку мы обучаем его на помеченном наборе обучающих данных, мы можем сравнить его выходные данные с фактическими правильными выходными данными.

Для наглядности предположим, что наш выходной словарь содержит только шесть слов («а», «я», «я», «спасибо», «ученик» и «

Выходной словарь нашей модели создается на этапе предварительной обработки еще до того, как мы начинаем обучение.

Как только мы определим наш выходной словарь, мы можем использовать вектор той же ширины для обозначения каждого слова в нашем словаре. Это также называется горячим кодированием. Так, например, мы можем обозначить слово «am» с помощью следующего вектора:

Пример: быстрое кодирование нашего выходного словаря

После этого резюме давайте обсудим функцию потерь модели — метрику, которую мы оптимизируем на этапе обучения, чтобы создать обученную и, надеюсь, удивительно точную модель.

Функция потерь

Допустим, мы обучаем нашу модель. Допустим, это наш первый шаг на этапе обучения, и мы обучаем его на простом примере — переводе слова «мерси» в «спасибо».

Это означает, что мы хотим, чтобы на выходе было распределение вероятностей с указанием слова «спасибо». Но поскольку эта модель еще не обучена, это вряд ли произойдет.

Поскольку все параметры модели (веса) инициализируются случайным образом, (необученная) модель создает распределение вероятностей с произвольными значениями для каждой ячейки / слова.Мы можем сравнить его с фактическим результатом, а затем настроить все веса модели, используя обратное распространение, чтобы сделать результат ближе к желаемому.

Как сравнить два распределения вероятностей? Мы просто вычитаем одно из другого. Для получения дополнительных сведений см. Кросс-энтропию и расхождение Кульбака – Лейблера.

Но учтите, что это упрощенный пример. Более реалистично, мы будем использовать предложение длиннее одного слова. Например — ввод: «je suis étudiant» и ожидаемый результат: «я студент».На самом деле это означает, что мы хотим, чтобы наша модель последовательно выводила распределения вероятностей, где:

- Каждое распределение вероятностей представлено вектором ширины vocab_size (6 в нашем игрушечном примере, но более реалистично число вроде 30 000 или 50 000)

- Первое распределение вероятностей имеет наивысшую вероятность в ячейке, связанной со словом «i»

- Второе распределение вероятностей имеет самую высокую вероятность в ячейке, связанной со словом «am»

- И так далее, пока пятое выходное распределение не укажет символ «

<конец предложения>», с которым также связана ячейка из словаря из 10 000 элементов.

Целевые распределения вероятностей, с которыми мы будем обучать нашу модель в обучающем примере для одного предложения-образца.

После обучения модели в течение достаточного времени на достаточно большом наборе данных мы надеемся, что полученные распределения вероятностей будут выглядеть следующим образом:

Надеемся, что после обучения модель выдаст правильный перевод, который мы ожидаем. Конечно, это не настоящее указание на то, была ли эта фраза частью обучающего набора данных (см .: перекрестная проверка).Обратите внимание, что каждая позиция имеет небольшую вероятность, даже если она вряд ли будет результатом этого временного шага — это очень полезное свойство softmax, которое помогает процессу обучения.

Теперь, поскольку модель производит выходные данные по одному, мы можем предположить, что модель выбирает слово с наибольшей вероятностью из этого распределения вероятностей и отбрасывает остальные. Это один из способов (называемый жадным декодированием). Другой способ сделать это — удержаться, скажем, за два верхних слова (например, «I» и «a»), а затем на следующем шаге запустить модель дважды: один раз предполагая, что первая выходная позиция была слово «I», и в другой раз, предполагая, что первой выходной позицией было слово «a», и какая бы версия ни вызвала меньше ошибок, учитывая обе позиции №1 и №2, сохраняется.Мы повторяем это для позиций №2 и №3… и т. Д. Этот метод называется «поиск луча», где в нашем примере для beam_size было два (это означает, что всегда две частичные гипотезы (незавершенные переводы) сохраняются в памяти), а top_beams также равно двум (что означает, что мы вернем два перевода. ). Это оба гиперпараметра, с которыми вы можете поэкспериментировать.

Двигайтесь вперед и трансформируйте

Надеюсь, вы нашли это полезным местом, чтобы начать ломать голову над основными концепциями Трансформера.Если вы хотите углубиться, я бы посоветовал следующие шаги:

Доработки:

Благодарности

Благодарим Илью Полосухина, Якоба Ушкорейта, Ллиона Джонса, Лукаша Кайзера, Ники Пармар и Ноама Шазира за отзывы о более ранних версиях этого поста.

Пожалуйста, напишите мне в Твиттер, чтобы я получил любые исправления или отзывы.

Вскрытие трансформатора

Рисунок 2: Уровень самовнимания Как мы теперь понимаем, хорошее представление слова должно учитывать его контекст в предложении (например, это уже одна из основных идей ELMo , ).Другими словами, вектор представления W (i) слова i должен учитывать слова W (1), ..., W (i-1) left из i и аналогично, слова W (i + 1), ..., W (n) справа от i . Это влечет за собой возможность каким-то образом связать слово с соседними словами. Это подводит нас ко второй идее, которая обычно используется в машинном обучении: как вы оцениваете, насколько связаны между собой двух элементов? Два продукта Amazon, два зрителя Netflix… или два слова в предложении? Обычно вы берете их точечный продукт (в соответствующем месте):

И вуаля, внимание к себе в простой версии. Чтобы перейти к более полной версии, нам нужно прояснить две вещи:

- Во-первых, как выглядят векторы

X (i)? Чем вы подпитываете слой самовнимания, то есть каково начальное представление каждого слова в предложении? Что ж, их можно вычислить несколькими способами. Например, вы можете использовать старый добрый tf-idf или идти в ногу с модой НЛП и использовать вложения слов (например, GloVe, Fasttext или Word2vec). - Во-вторых, что на самом деле означает связанных слов? Много вещей! Например, два слова в предложении могут быть связаны отношением субъект-глагол (слова «птица» и «имеет» разделяют это отношение). В идеале мы хотели бы, чтобы скалярное произведение между встраиваемыми этими двумя словами — и всеми словами, имеющими одно и то же грамматическое отношение — было высоким и, наоборот, было низким для слов, которые не имеют этого грамматического отношения. Плохая новость заключается в том, что ваши готовые заранее вычисленные вложения слов не были обучены отвечать на этот конкретный вопрос.Хорошая новость заключается в том, что мы все еще можем использовать эти предварительно вычисленные вложения и настраивать их как часть всего обучения трансформерам.

Три вложения по цене одного

Теперь давайте сделаем шаг назад и подумаем, как должно вести себя встраивание W (i) слова i . Здесь я хочу, чтобы вы обратили внимание, что этот единственный вектор на самом деле используется в трех разных задачах! (Ниже я перефразирую этот пост в блоге):

1- Для вычисления нового представления слова i : В скалярном произведении будет использоваться вложение W (i) с другими словами W (j) предложения, чтобы вычислить веса для каждого слова.

2- Для вычисления новых представлений других слов в предложении j : Вложение W (i) будет использоваться в скалярном произведении с этими словами для вычисления веса для каждого слова.

3- Для вычисления нового представления слова i : Вложение W (i) будет использоваться как слагаемое окончательной взвешенной суммы.

Здесь мы подходим к еще одной гениальной идее этой статьи. Вместо того, чтобы изучать для каждого слова одно вложение для выполнения этих трех задач, почему бы не изучить разные вложения слов для каждой задачи? Переход от универсального к трем специализированным вложениям для каждого слова. Мы будем называть встраивание для задачи 1 запросом , для задачи 2 ключ , а для задачи 3 значение .

Давайте теперь вернемся к цифре 3:

Рисунок 4: Шаг softmax не представлен для ясности.Допустим, мы хотим вычислить репрезентацию внимания слова «птица». ” Сначала мы измеряем, как это слово соотносится со всеми другими словами в том же предложении: Маленькая птичка полетела .

Мы делаем это, взяв скалярное произведение вектора Query , Q (птица) , с Key всех других слов, K (the), ..., K (flight) , давая вектор весов для всех слов в предложении: α (the),…, α (полет).Затем мы используем эти веса в взвешенной сумме векторов Value всех слов в предложении V (the), ..., V (nest) .

И поскольку все эти операции независимы, их можно векторизовать:

Самовнимание в векторизованном виде.Это действительно суть! Я намеренно опустил некоторые детали истинной реализации (такие как нормализующая константа, уровень прямой связи, остаточные соединения и т. Д.). Я предлагаю вам прочитать оригинал статьи, чтобы осветить их.Если вы хотите получить более подробную информацию о параметрах Query , Key, и Value , я рекомендую вам ознакомиться с отличным сообщением Джея Аламмара о трансформаторах.

Глазурь на торте: внимание с несколькими головами

«Ну, держись», — скажете вы. «Я понимаю, что нам нужно обучить новые вложения, чтобы улавливать отношение подлежащее к глаголу , но как насчет других отношений, которые могут существовать?» Хорошо поймал. В конце концов, вы также можете сделать вывод, что «птица» и «ее» связаны отношением притяжательного к существительному.

Решение этой проблемы простое: для каждого слова создайте столько различных вложений, сколько есть отношений, которые мы можем захотеть зафиксировать. Это означает наличие нескольких параллельных слоев самовнимания вместо одного. Это называется многоголовое внимание .

В исходной статье использовалось 8 голов.Последний призыв к порядку: позиционное кодирование

Вы могли заметить, что мы ни разу не упомянули порядок слов в предложении.Это ожидается; операция самовнимания инвариантна к перестановкам. То есть результат будет одинаковым независимо от того, как вы переставляете слова в предложении. Но это, конечно, не помешало авторам навести некоторый порядок в бардаке.

Авторы предлагают представить эту информацию модели, добавив к каждому слову вектор вложения размерности d_model , вектор того же размера. Это позиционное кодирование вектора теоретически сообщило бы модели о положении этого слова в предложении.Сформулируем сначала эти векторы.

В качестве примера вектор позиционного кодирования слова bird в предложении: Маленькая птичка взлетела (здесь мы берем d_model = 300 ):

Что такое нейронные сети-трансформаторы?

Описание нейронных сетей с трансформатором

Трансформаторы — это тип модели машинного обучения, который специализируется на обработке и интерпретации последовательных данных, что делает их оптимальными для задач обработки естественного языка.Чтобы лучше понять, что такое трансформаторы машинного обучения и как они работают, давайте подробнее рассмотрим модели трансформаторов и механизмы, которые ими управляют.

В этой статье будут рассмотрены следующие вопросы:

- Модели от последовательности к последовательности

- Архитектура нейронной сети трансформатора

- Механизм внимания

- Различия между трансформаторами и RNN / LSTM

Модель от последовательности к последовательности

–9000 К последовательностям относятся модели НЛП, которые используются для преобразования последовательностей одного типа в последовательность другого типа.Существуют различные типы моделей от последовательности к последовательности, такие как модели рекуррентной нейронной сети и модели с длительной краткосрочной памятью (LSTM).Традиционные модели «последовательность-последовательность», такие как RNN и LSTMS, не являются предметом этой статьи, но их понимание необходимо для понимания того, как работают модели трансформаторов и почему они превосходят традиционные модели «последовательность-последовательность».

Вкратце, модели RNN и модели LSTM состоят из сетей кодеров и декодеров, которые анализируют входные данные на различных временных шагах.Модель кодировщика отвечает за формирование закодированного представления слов во входных данных. На каждом временном шаге сеть кодировщика принимает входную последовательность и скрытое состояние из предыдущего временного шага в серии. Значения скрытого состояния обновляются по мере прохождения данных по сети до последнего временного шага, на котором создается «вектор контекста». Затем вектор контекста передается в сеть декодера, которая используется для генерации целевой последовательности путем прогнозирования наиболее вероятного слова, которое сочетается с входным словом для соответствующих временных шагов.

Эти модели могут быть расширены за счет использования «механизма внимания». Механизм внимания определяет, на каких частях входного вектора сеть должна сосредоточиться, чтобы сгенерировать правильный результат. Другими словами, механизм внимания позволяет модели преобразователя обрабатывать одно входное слово, одновременно обращая внимание на соответствующую информацию, содержащуюся в других входных словах. Механизмы внимания также маскируют слова, не содержащие релевантной информации.

Архитектура нейронной сети с трансформатором

Мы рассмотрим механизм внимания более подробно позже, а пока давайте рассмотрим архитектуру нейронной сети с трансформатором на более высоком уровне.

В целом нейронная сеть-преобразователь выглядит примерно так:

Хотя эта общая структура может меняться между сетями, основные части останутся прежними: позиционное кодирование, векторы слов, механизм внимания, нейронная сеть с прямой связью. .

Позиционные кодировки и векторы словТрансформаторные нейронные сети работают, принимая последовательность входных данных и преобразовывая эти входные данные в две другие последовательности.Преобразователь производит последовательность вложений векторов слов и позиционных кодировок.

Векторные вложения Word — это просто текст, представленный в числовом формате, который может обрабатывать нейронная сеть. Между тем, позиционные кодировки представляют собой векторизованные представления, содержащие информацию о позиции текущего слова во входном предложении по отношению к другим словам.

Другие текстовые модели нейронных сетей, такие как RNN и LSTM, используют векторы для представления слов во входных данных.Эти векторные вложения отображают слова в постоянные значения, но это ограничение, потому что слова могут использоваться в разных контекстах. Трансформаторная сеть решает эту проблему, делая значения слов более гибкими, используя синусоидальные функции, позволяющие векторам слов принимать разные значения в зависимости от положения слова в предложении.

Это позволяет модели нейронной сети сохранять информацию об относительном положении входных слов даже после того, как векторы перемещаются через слои трансформаторной сети.

Позиционное кодирование и встраивание векторов слов суммируются, а затем передаются в сети кодировщика и декодера. Хотя нейронные сети-трансформеры используют схемы кодировщика / декодера точно так же, как RNN и LSTM, одно из основных различий между ними заключается в том, что все входные данные передаются в сеть одновременно, тогда как в RNN / LSTM данные передаются последовательно.

Сети кодировщиков отвечают за преобразование входных данных в представления, из которых сеть может учиться, в то время как сети декодеров делают обратное и преобразуют кодировки в распределение вероятностей, используемое для генерации наиболее вероятных слов в выходном предложении.Важно отметить, что и у кодировщиков, и у декодеров есть механизм внимания.

Поскольку графические процессоры могут выполнять параллельную обработку, параллельно используются несколько механизмов внимания, вычисляющих релевантную информацию для всех входных слов. Эта способность обращать внимание на несколько слов, получившая название «внимание нескольких голов», помогает нейронной сети узнавать контекст слова в предложении, и это одно из основных преимуществ трансформаторных сетей перед RNN и LSTM.