Механизмы трансформации

IFAGRIDRelaxАккордеонВперед раскладнойДельфинЕврокнижкаКлик-клякКнижкаСедафлексТик-такФранцузская раскладушка

IFAGRID

Механизм IFAGRID хорош тем, что благодаря ему диван в разложенном состоянии выглядит совсем как настоящая широкая кровать. Суть механизма проста – его каркас встроен в сиденье. Для того, чтобы разложить диван, нужно просто убрать подушки с сиденья и потянуть за верхнюю часть механизма. И диван превращается в удобную и мягкую кровать.

Механизм IFAGRID очень похож на «Французскую раскладушку», однако в отличие от нее, он подходит для ежедневного использования.

Плюсы:

- Большое спальное место

- Раскладывание в три шага

- Усиленная конструкция

Минусы:

- Отсутствие ящика для постельного белья

- Необходимо убирать диванные подушки

Диваны Пинскдрев c механизмом трансформации IFAGRID:

Все диваны с механизмом IFAGRID

Аккордеон

Главная характеристика этих механизмов – это их высокая надежность и простота трансформации. В собранном виде диваны Аккордеон занимают минимальную площадь, но при этом они имеют значительную величину спального места. Диваны с механизмом аккордеон имеют одну особенность, которую необходимо учитывать при их покупке – они требуют значительного пространства для трансформации.

Главная характеристика этих механизмов – это их высокая надежность и простота трансформации. В собранном виде диваны Аккордеон занимают минимальную площадь, но при этом они имеют значительную величину спального места. Диваны с механизмом аккордеон имеют одну особенность, которую необходимо учитывать при их покупке – они требуют значительного пространства для трансформации.Плюсы:

- Простота трансформации

- Высокое и широкое спальное место

- Легкость и прочность

Минусы:

- Отсутствие ящика для постельного белья

- Пружинный механизм требует ухода

- Ограничения по весу

Диваны Пинскдрев c механизмом трансформации Аккордеон:

Все диваны с механизмом Аккордеон

Вперед раскладной

Современный механизм трансформации диванов «Вперед раскладной» отличается удобством и простотой использования. Такие механизмы трансформации диванов с одинаковым успехом применяются в двухместных диванах-кроватях, рассчитанных на ежедневное использование, и в компактных креслах-кроватях.

Плюсы:

- Легкость трансформации

- Большое спальное место

- Наличие бельевого ящика

Минусы:

- Низкое расположение спального места

- Есть ограничения по максимальной нагрузке

Диваны Пинскдрев c механизмом трансформации Вперед раскладной:

Все диваны с механизмом Вперед раскладной

Дельфин

Механизм трансформации Дельфин позволяет сделать из любого углового дивана большую двуспальную кровать и просторное спальное место. Механизм дельфин используется как раз в основном для угловых диванов. Механизмы для мягкой мебели чрезвычайно просты. Угловая часть дивана как раз является частью спального места. А вторая, более широкая часть спрятана в потайном ящике, расположенным под сидением дивана.

Плюсы:

- Простота трансформации

- Большое спальное место

- Наличие ящика для белья

- Надежность

Минусы:

- При неаккуратном обращении можно повредить напольное покрытие

Диваны Пинскдрев c механизмом трансформации Дельфин:

Все диваны с механизмом Дельфин

Еврокнижка

Механизм Еврокнижка давно известен всем и пользуется большой популярностью.

Плюсы:

- Компактность

- Простота трансформации

- Наличие ящика для белья

Минусы:

- Необходимо размещать на расстоянии от стены

- При неаккуратном обращении можно повредить напольное покрытие

Диваны Пинскдрев c механизмом трансформации Еврокнижка:

Клик-кляк

Механизм трансформации «Клик-клак» является более совершенной моделью «Книжки», ведь кроме стандартных положений спинки «лежа» и «сидя», он также позволяет расположить её под определенным углом. Схема работы механизма достаточно проста: снимаем подушки, поднимаем сиденье и спинки до щелчка и опускаем их вниз, создавая ровную спальную поверхность.

Плюсы:

- Ровная спальная поверхность

- Наличие ящика для белья

Минусы:

- Требуется некоторое усилие для трансформации

- Необходимо размещать на расстоянии от стены

Диваны Пинскдрев c механизмом трансформации Клик-кляк:

Все диваны с механизмом Клик-кляк

Книжка

Механизм трансформации диванов Книжка является наиболее известным и привычным механизмом, зарекомендовавшим себя уже давно и до сих пор не потерявшим свою популярность. Свое название «Книжка» он получил благодаря тому, что раскладывание такого механизма напоминает развернутую книгу. Такой механизм трансформации неизменно пользуется популярностью у наших сограждан из-за своего удобства, комфортности и долговечности. Диван-книжка очень легко трансформируется в кровать (кушетку, тахту) и также легко опять становится диваном при помощи обычного шарнирного механизма.

Плюсы:

- Ровная спальная поверхность

- Наличие ящика для белья

Минусы:

- Требуется некоторое усилие для трансформации

- Необходимо размещать на расстоянии от стены

Диваны Пинскдрев c механизмом трансформации Книжка:

Все диваны с механизмом Книжка

Седафлекс

Седафлекс – один из самых популярных механизмов трансформации из-за его простоты и надежности. Этот механизм дивана относится к тому типу конструкций, которым можно пользоваться ежедневно. Раскладывается на “раз-два”, поэтому седафлекс и называется двускладным механизмом, с ним могут справиться даже дети. Надо потянуть его вверх и на себя, развернуть обе секции конструкции и расправить ножки. А в сложенном виде механизм не влияет ни на дизайн, ни на размеры дивана. Жесткость и прочность конструкции сохраняется благодаря каркасу, изготовленному из высокопрочных стальных труб, и двух поперечных элементов. Это и позволяет Седафлексу справляться с большими нагрузками. Так как механизм не имеет соединений из дерева или пластика, он может прослужить долго даже при ежедневном использовании.

Этот механизм дивана относится к тому типу конструкций, которым можно пользоваться ежедневно. Раскладывается на “раз-два”, поэтому седафлекс и называется двускладным механизмом, с ним могут справиться даже дети. Надо потянуть его вверх и на себя, развернуть обе секции конструкции и расправить ножки. А в сложенном виде механизм не влияет ни на дизайн, ни на размеры дивана. Жесткость и прочность конструкции сохраняется благодаря каркасу, изготовленному из высокопрочных стальных труб, и двух поперечных элементов. Это и позволяет Седафлексу справляться с большими нагрузками. Так как механизм не имеет соединений из дерева или пластика, он может прослужить долго даже при ежедневном использовании.

Плюсы:

- Простота трансформации

- Большое спальное место

Минусы:

- Отсутствие ящика для белья

- Ограничение в нагрузках

Диваны Пинскдрев c механизмом трансформации Седафлекс:

Все диваны с механизмом Седафлекс

Тик-так

Механизм Тик-Так — это шагающий механизм позволяет уберечь ваш паркет или ковровое покрытие от следов роликов и ножек дивана-кровати. Раскладываясь, механизм трансформации Тик-Так приподнимается над полом, а затем аккуратно встает на него.

Раскладываясь, механизм трансформации Тик-Так приподнимается над полом, а затем аккуратно встает на него.

Плюсы:

- Простота трансформации

- Наличие ящика для белья

Минусы:

Диваны Пинскдрев c механизмом трансформации Тик-так:

Все диваны с механизмом Тик-так

Французская раскладушка

Французский механизм идеально подходят для диванов, которые не часто используются в качестве спального места. Этот механизм трансформации еще называют «гостевым», словно подчеркивая его предназначение. И вправду, если в вашем доме иногда остаются на ночлег припозднившиеся гости, то механизм французская раскладушка – самый лучший вариант для дивана в вашей гостиной.

Плюсы:

- Компактность

- Простота трансформации

Минусы:

- Отсутствие ящика для постельного белья

- Не идеально ровная спальная поверхность

Диваны Пинскдрев c механизмом трансформации Французская раскладушка:

Все диваны с механизмом Французская раскладушка

Relax

Уникальный механизм RELAX, которым оснащены некоторые модели кресел нашей компании, позволяет сидящему человеку при откидывании на спинку кресла синхронно выдвигать вперёд сидение и стенку переднюю, которая превращается в дополнительную выдвижную подставку для ног. Кресло автоматически подстраивается под человека и позволяет ему принимать правильную эргономичную позу, тем самым снизить кровяное давление в области коленных суставов, а также правильно распределить нагрузку на шейные позвонки.

Кресло автоматически подстраивается под человека и позволяет ему принимать правильную эргономичную позу, тем самым снизить кровяное давление в области коленных суставов, а также правильно распределить нагрузку на шейные позвонки.

Плюсы:

- Обеспечение правильного эргономического положения

- Легкость раскладывания

- Надежность конструкции

Минусы:

- Невозможность размещения вплотную к стене

Кресла Пинскдрев c механизмом трансформации Relax:

Механизм трансформации вертикальной шкаф-кровати 582

Общие положения

Некоторые объекты, размещенные на сайте, являются интеллектуальной собственностью компании StoreLand. Использование таких объектов установлено действующим законодательством РФ.

На сайте StoreLand имеются ссылки, позволяющие перейти на другие сайты. Компания StoreLand не несет ответственности за сведения, публикуемые на этих сайтах и предоставляет ссылки на них только в целях обеспечения удобства для посетителей своего сайта.

Личные сведения и безопасность

Компания StoreLand гарантирует, что никакая полученная от Вас информация никогда и ни при каких условиях не будет предоставлена третьим лицам, за исключением случаев, предусмотренных действующим законодательством Российской Федерации.

В определенных обстоятельствах компания StoreLand может попросить Вас зарегистрироваться и предоставить личные сведения. Предоставленная информация используется исключительно в служебных целях, а также для предоставления доступа к специальной информации.

Личные сведения можно изменить, обновить или удалить в любое время в разделе «Аккаунт» > «Профиль».

Чтобы обеспечить Вас информацией определенного рода, компания StoreLand с Вашего явного согласия может присылать на указанный при регистрации адрес электронный почты информационные сообщения. В любой момент Вы можете изменить тематику такой рассылки или отказаться от нее.

Как и многие другие сайты, StoreLand использует технологию cookie, которая может быть использована для продвижения нашего продукта и измерения эффективности рекламы. Кроме того, с помощь этой технологии StoreLand настраивается на работу лично с Вами. В частности без этой технологии невозможна работа с авторизацией в панели управления.

Сведения на данном сайте имеют чисто информативный характер, в них могут быть внесены любые изменения без какого-либо предварительного уведомления.

Чтобы отказаться от дальнейших коммуникаций с нашей компанией, изменить или удалить свою личную информацию, напишите нам через форму обратной связи

Механизмы трансформации диванов и кресел

В статье представлены основные особенности различных механизмов трансформации:

«СЕДАФЛЕКС»

Один из самых популярных механизмов трансформации из-за его простоты и надежности. Подходит для ежедневного использования, при разложении образует удобное, ровное спальное место повышенной комфортности. По праву называется «бельгийской кроватью», механизм разработан, запатентован и выпускается франко-бельгийской фирмой SEDAC-MERAL. Максимальная нагрузка на механизм 240кг. Бельевого ящика нет. Раскладка и сон по направлению от стены. Данный механизм трансформации используется в следующих диванах: «Рафаэль».

По праву называется «бельгийской кроватью», механизм разработан, запатентован и выпускается франко-бельгийской фирмой SEDAC-MERAL. Максимальная нагрузка на механизм 240кг. Бельевого ящика нет. Раскладка и сон по направлению от стены. Данный механизм трансформации используется в следующих диванах: «Рафаэль».

ПРЕИМУЩЕСТВА:

- Механизм компактный и прячется в диване, позволяя совместить интересный дизайн, комфортную посадку и наличие полноценного спального места.

- Отличительная особенность: наличие пружинного матраса толщиной 10-12 см. Ровное спальное место без стыков.

- В основании спального места под матрасом ортопедические березовые латы, либо металлическая сетка из стали большого сечения, именно это позволяет сравнивать механизм с кроватью. В зоне ног – настил из резинотканевых ремней, который в сложенном виде становится основанием для подушек сиденья и залогом истинного комфорта посадки.

- Оптимальная высота спального места (45 см от пола).

- Центральной опорой спального места служит усиленная стальная «нога», которая и обеспечивает максимальную надежность в эксплуатации.

- Механизм предназначен для ежедневного использования.

КАК РАСКЛАДЫВАТЬ:

Снять подушки сиденья, потянуть механизм вверх и на себя, развернуть звенья, при трансформации становится на стальные ножки – диван разложен.

«МИКСОТОЙЛ»

«Миксотойл» («Французская раскладушка») – механизм, используемый как «гостевой вариант» спального места. Бельевого ящика нет. Максимальная нагрузка на механизм 180 кг. Раскладка и сон по направлению от стены.

ПРЕИМУЩЕСТВА:

- Механизм компактный и прячется в диване, позволяя даже в небольшом диване встроить дополнительное гостевое спальное место.

- Поролоновый беспружинный матрац толщиной 5-6 см имеет съемный чехол, что существенно облегчает уход за изделием. Со временем, возможна замена матраса и чехла.

- Гигиеничность спального места (сидим на обивке дивана, а спим на матрасе).

- В основании спального места ортопедические березовые ламели и натяжной элемент в виде полипропиленового тента.

КАК РАСКЛАДЫВАТЬ:

Снять подушки сиденья, потянуть механизм вверх и на себя, развернуть звенья, при трансформации становится на стальные опоры – диван разложен.

«ИФАГРИД» («СПАРТАК»)

Механизм похожий на «Миксотойл» («французская раскла душка»), но спроектированный для ежедневного использования. Производится франко-бельгийской компанией «Седак Мераль» и по лицензии несколькими дочерними предприятиями на территории России. Максимальная нагрузка на механизм 240 кг. Бельевого ящика нет. Раскладка и сон по направлению от стены. Данный механизм трансформации используется в следующих диванах: Lofft, Maxbon, «Брайтон», «Велидж», «Жаклин», «Фьюжн», «Флерон», «Шерон».

ПРЕИМУЩЕСТВА:

- Усиленный стальной каркас.

Основание спального места — сетчатая стальная решетка.

Основание спального места — сетчатая стальная решетка. - Не имеет деревянных и пластиковых соединений, за счет этого обеспечивается надежность и долговечность.

- Поролоновый беспружинный матрас толщиной 7 см имеет съемный чехол, что существенно облегчает уход за изделием. Со временем, возможна замена матраса и чехла.

- Спальное место формируется одним ровным цельным матрасом без стыков.

Рекомендуемые статьи по данной теме:

КАК РАСКЛАДЫВАТЬ:

Снять подушки сиденья, потянуть механизм вверх и на себя, развернуть звенья, при трансформации становится на стальные опоры – диван разложен.

«ТИК-ТАК»

Механизм предназначен для ежедневного использования. Он прочен и прост в эксплуатации. В основании спального места два одинаковых мягких элемента, спинка и сиденье. Максимальная нагрузка на механизм 240 кг. Раскладка и сон по направлению вдоль стены. Данный механизм трансформации используется в следующих диванах: «Тринити», «Морган», Bormio, Gabrisa, «Соренто».

ПРЕИМУЩЕСТВА:

- Легкость трансформации.

- Не оставляет следов на напольных покрытиях и коврах, так как перемещается на направляющих, совершая движение-шаг в пространстве. Не используются колесики, что исключает трение с поверхностью пола.

- Под сиденьем находится вместительный бельевой ящик.

- Удобное и просторное спальное место.

- Повышенная степень надежности механизма при ежедневном использовании.

- При раскладке не требуется убирать подушки сиденья.

КАК РАСКЛАДЫВАТЬ:

Для того, чтобы разложить диван нужно снять подушки спинки, затем, взявшись за низ передней части дивана, легким движением вверх и вперед выдвинуть сиденье на себя и аккуратно опустить его на пол. На освободившееся место опустить спинку.

«ТЕЛЕСКОП»

Выкатной или выдвижной механизм трансформации. Особенность конструкции позволяет сделать спальное место высотой только 30 см. Рекомендует как «гостевой вариант» спального места. Максимальная нагрузка 180 кг. Раскладка и сон по направлению от стены.

Рекомендует как «гостевой вариант» спального места. Максимальная нагрузка 180 кг. Раскладка и сон по направлению от стены.

ПРЕИМУЩЕСТВА:

- Простой в эксплуатации механизм.

- В основании спального места два одинаковых мягких элемента, спинка и сиденье.

- Часто в средней части дивана есть бельевой ящик.

- Компактность в сложенном виде и большое спальное место – в разложенном виде.

КАК РАСКЛАДЫВАТЬ:

Конструкция состоит из 3 частей. Для трансформации в положение «кровать» необходимо выкатить вперед переднюю секцию с сиденьем, при этом из спинки выдвигается подголовник, и уложить сиденье-подушку в образовавшуюся нишу.

«HODRY»

Механизм премиум-класса с электроприводом, производства Австрия. Подходит для ежедневного использования. По принципу разложения – это выкатной механизм. Для трансформации диван-кровати в положение «кровать» достаточно нажать одну кнопку на пульте дистанционного управления. Есть ящик для постельных принадлежностей.

Есть ящик для постельных принадлежностей.

«ВПЕРЕД РАСКЛАДНОЙ»

Удобный механизм, который применяется в двухместных диван-кроватях и креслах-кроватях. В основании спального места два одинаковых мягких элемента, спинка и сиденье. Максимальная нагрузка 200 кг. Есть бельевой ящик. Подходит для ежедневного использования.

КАК РАСКЛАДЫВАТЬ:

- Взявшись за тканевую ручку, закрепленную внизу сидения дивана или в нижней части спинки, поднять передний мягкий элемент спинки вверх, а затем установить его вертикально.

- Поднять вверх сиденье дивана за его переднюю стенку, и перемещая его вперед и на себя, поставить опорами на пол. При этом открывается доступ к вместительному ящику для постельных принадлежностей.

«ПУМА»

Механизм «Пума» предназначен для ежедневного использования и является представителем нового, современного типа механизмов трансформации. Механизм состоит из металлических пружин и противовесов, компенсирующих возможные усилия при раскладке дивана. Прост и надежен в использовании. Бельевого ящика нет. Данный механизм трансформации используется в следующих диванах: «Сиэтл».

Прост и надежен в использовании. Бельевого ящика нет. Данный механизм трансформации используется в следующих диванах: «Сиэтл».

ПРЕИМУЩЕСТВА:

- Потрясающая легкость трансформации.

- Не оставляет следов на напольных покрытиях и коврах, так как перемещается на направляющих, совершая поступательное движение-шаг в пространстве. Не используются колесики, что исключает трение с поверхностью пола.

- Комфортное спальное место, сложившееся из двух мягких элементов.

- При раскладке не требуется убирать подушки сиденья.

КАК РАСКЛАДЫВАТЬ:

Раскладка осуществляется путем перемещения сиденья вперед «шагающим» способом. Возьмитесь за специальную петлю подъема (если она есть) или за низ дивана и приподнимите его. В первые же секунды механизм возьмет всю нагрузку на себя и при минимальном усилии с вашей стороны сиденье переместится и сделает шаг вперед. Одновременно с перемещением сиденья вперед автоматически осуществляется подъем мягкого элемента, находящегося в нише под сиденьем. Сиденье и дополнительный мягкий элемент образуют единое спальное место.

Сиденье и дополнительный мягкий элемент образуют единое спальное место.

«ДЕЛЬФИН»

Популярный и удобный механизм для ежедневного применения. Чаще всего, используется в угловых диванах. В основании спального места: сиденье дивана и выдвижной блок, расположенный под сиденьем. Максимальная нагрузка 200 кг. Прочный и надежный механизм. Данный механизм трансформации используется в следующих диванах:«Престон», «Лаунж-2», «Стив».

ПРЕИМУЩЕСТВА:

- В угловых диванах просторное спальное место.

- Легкость трансформации, практически не требуется усилий при раскладывании.

- Надежный стальной механизм, направляющие из твердых пород древесины продлевают срок службы конструкции.

- Не требует дополнительного пространства, раскладка в границах общих габаритов дивана.

- Легкость раскладки позволяет в считанные секунды превратить диван в большую зону для отдыха для нескольких человек. Вы можете расположиться на нем с комфортом, вытянув ноги и облокотившись на подушки спинки.

- При раскладке не требуется убирать подушки сиденья.

КАК РАСКЛАДЫВАТЬ:

Выдвинуть на себя встроенный потайной ящик из-под сиденья дивана. Потянув за ремешок, вытянуть дополнительную секцию, чтобы она сравнялась с высотой сиденья и «достроила» спальное место до полноценного размера.

«ЕВРОКНИЖКА»

«Еврокнижка» — один из самых популярных и востребованных механизмов для ежедневного сна. Очень прост и надежен в использовании. Имеет направляющие из твердых пород древесины или фанеры, по которым передвигаются ролики, установленные сзади внизу сиденья. Передняя часть сиденья также опирается колесными опорами на пол. Под сиденьем всегда имеется вместительный бельевой ящик. Максимальная нагрузка на механизм 240 кг. Раскладка и сон по направлению вдоль стены. Данный механизм трансформации используется в следующих диванах:«Толедо».

ПРЕИМУЩЕСТВА:

- Максимально простая конструкция механизма гарантирует повышенную надежность при ежедневной трансформации.

- Легкость трансформации.

- При раскладке не требуется убирать подушки сиденья.

- В основании спального места два одинаковых мягких элемента: спинка и сиденье.

КАК РАСКЛАДЫВАТЬ:

Для того, чтобы разложить механизм: снять подушки спинки, сиденье вытягивается на себя, на освободившееся место опускается спинка. Готово.

«РИБАЛТО»

Mеханизм двойного сложения «Рибалто» — спальное место, состоящее из трех частей, две из которых являются до трансформации основанием сидения, а третья, складываясь, образует спинку. Механизм трансформации «Рибалто» обеспечивает легкость и оперативность раскладывания. Диваны с механизмом «Рибалто» в собранном виде занимают минимальную площадь, а при раскладывании имеют широкое и высокое спальное место с комфортным ровным матрацем.

«АККОРДЕОН»

Один из самых востребованных механизмов для гостевого использования. Работает по принципу гармошки, что обеспечивает легкость и оперативность раскладывания. Диваны с механизмом аккордеон в собранном виде занимают минимальную площадь, а при раскладывании имеют широкое и высокое спальное место. Раскладка и сон по направлению от стены. Рекомендуемая нагрузка 160 кг.

Диваны с механизмом аккордеон в собранном виде занимают минимальную площадь, а при раскладывании имеют широкое и высокое спальное место. Раскладка и сон по направлению от стены. Рекомендуемая нагрузка 160 кг.

ПРЕИМУЩЕСТВА:

- Экономия пространства.

- Для раскладки не требуется дополнительно убирать никакие элементы с дивана.

- Раскладка одним движением.

- Легкая и простая раскладка.

- Повышенная степень надежности механизма при ежедневном использовании (срок 10 лет).

- Ровное и просторное спальное место без стыков.

КАК РАСКЛАДЫВАТЬ:

Потяните сиденье дивана вперед, используя специальную петлю или просто схватившись за нижнюю часть изделия. Тяните до тех пор, пока диван полностью не разложится в кровать.

«КНИЖКА»

Для трансформации диван-кровати в положение кровать приподнимается сидение, при этом спинка дивана опускается в горизонтальное положение. Сиденье поднимается далее, до характерного щелчка, после этого опускается также в горизонтальное положение. Для механизма «книжка» необходимо наличие небольшого пространства между спинкой и стеной.Под сиденьем находится вместительный бельевой ящик. Спальное место располагается вдоль стены (важно для владельцев малогабаритных квартир).

Сиденье поднимается далее, до характерного щелчка, после этого опускается также в горизонтальное положение. Для механизма «книжка» необходимо наличие небольшого пространства между спинкой и стеной.Под сиденьем находится вместительный бельевой ящик. Спальное место располагается вдоль стены (важно для владельцев малогабаритных квартир).

«ПУМА ВЫКАТНОЙ»

Интересная разновидность механизма «Пума», которая устанавливается в компактные диваны (длина 210-220) и дает возможность иметь полноценное спальное место для ежедневного сна. Одна из последних разработок в механизмах трансформации, производство — Польша. Механизм основан на принципе синхронизации движений, прост и надежен в использовании. Бельевого ящика нет.

ПРЕИМУЩЕСТВА:

- Потрясающая легкость трансформации.

- При раскладке не требуется убирать подушки сиденья.

- Позволяет иметь полноценное и долговечное спальное место в компактных диванах.

Чтобы механизм трансформации служил долго, необходимо соблюдать следующие правила эксплуатации:

- В сложенном механизме может находиться только матрас, поставленный в комплекте изделия.

В сложенном механизме не допускается присутствие спальных принадлежностей и посторонних предметов.

В сложенном механизме не допускается присутствие спальных принадлежностей и посторонних предметов. - При трансформации механизма не следует допускать попадания постельных принадлежностей, посторонних предметов и пальцев между подвижными элементами механизма.

- В случае затрудненного раскладывания или складывания проверьте отсутствие посторонних предметов в шарнирных соединениях, не прилагая излишних усилий.

- Не рекомендуется садиться или опираться на края механизма, не имеющие опоры: подголовник, ножную секцию.

«NEW ROLLER»

Механизм трансформации «New Roller» уникален среди своих собратьев: диван раскладывается с изголовья, благодаря этому подушки снимать не надо — они уходят под низ дивана. Разработан Бельгийской компанией Sedak-meral и, также как и все остальные механизмы этой компании, имеет высокое качество сборки и используемого материала.

ПРЕИМУЩЕСТВА:

- Не встраивается в диван и по сути является основой дивана или его каркасом.

- Не имеет аналогов в простоте сложения-раскладки.

- Возможность прикрутить спинку дивана на дому у покупателя, делает диван «проходимым» в любые дверные проемы.

- Данный механизм выдерживает нагрузку до 500 кг.

- Можно использовать матрас толщиной до 140 мм, что значительно расширяет количество допустимых матрасов к этой модели механизма.

- Каркас выполнен из высококачественной стали толщиной стенок 3 мм.

- Стальная решётка из которой выполнено спальное место занимает 2/3 его поверхности и обеспечивает надёжное и удобное спальное место даже для людей с проблемами позвоночника.

«ЛУКА D30»

В качестве спального места используется механизм трансформации Российского производства «Лука D30» двойного сложения.

Глубина в сложенном состоянии 780 мм. Спальная поверхность в местах наибольшей нагрузки выполнена из сварной сетки, диаметр прутка 4 мм. В ножной части эластичные ремни. Ремни так же позволяют получить более комфортное сидячее место в положении диван. Нагрузка воспринимается не только подушкой дивана, но и матрацем механизма. Тяги выполнены из 5 мм стальной полосы. Данное решение позволяет добиться наибольшей надежности и долговечности работы данного соединения. Головная часть выполнена как единый силовой элемент, состоящий из: П- образной дуги, поперечной трубы диаметром 30 мм с толщиной стенки 1,5 мм, связанные между собой сварной сеткой.

Нагрузка воспринимается не только подушкой дивана, но и матрацем механизма. Тяги выполнены из 5 мм стальной полосы. Данное решение позволяет добиться наибольшей надежности и долговечности работы данного соединения. Головная часть выполнена как единый силовой элемент, состоящий из: П- образной дуги, поперечной трубы диаметром 30 мм с толщиной стенки 1,5 мм, связанные между собой сварной сеткой.

ОСОБЕННОСТИ:

- Данный механизм в разложенном виде позволяет получить спальное место размером 1620 х 1890 мм.

- Высота механизма в разложенном виде до верхнего края матраса составляет 410 мм.

«РАНУЧЧИ»

Итальянцы, законодатели мебельной моды, уверены: сидеть и спать надо на разных элементах дивана, т.к. для сидения требуется более мягкий наполнитель, а для здорового сна – более твёрдый. Механизм двойного сложения «Рануччи» — это уникальный механизм для ежедневного сна, комфорт которого сравним с полноценной кроватью. Спальное место состоит из трех частей, две из которых являются до трансформации основанием сиденья, а третья, складываясь, образует спинку. Диваны с механизмом «Рануччи» в собранном виде занимают минимальную площадь, т.к. сам механизм «Рануччи» является и диваном и спальным местом одновременно, что позволяет экономить пространство в жилом помещении.

Спальное место состоит из трех частей, две из которых являются до трансформации основанием сиденья, а третья, складываясь, образует спинку. Диваны с механизмом «Рануччи» в собранном виде занимают минимальную площадь, т.к. сам механизм «Рануччи» является и диваном и спальным местом одновременно, что позволяет экономить пространство в жилом помещении.

Механизм раскладывается за одно движение, подушки сидения и спинки не надо снимать, т.к. они уходят под спальное место. В результате раскладывания мы получаем отличное спальное место, без стыков, без перепадов уровня (что часто бывает, когда используются различные выкатные системы). Матрац сделан из из качественного пенополиуретана, и опорой для него является сварная стальная сетка, закреплённая на раме механизма с помощью пружин (это создаёт дополнительный комфорт).

Рама механизма сделана из стальных труб, а детали само го механизма – из стального листа. Простоту, комфорт и надежность механизма «Рануччи» по достоинству оценила и выбрала для своей мебели такая всемирно известная сеть отелей, как «Hilton» («Хилтон»).

Механизмы трансформации диванов — Лучшие решения от фабрики Умные Диваны

Для комфортного и здорового сна каждую ночь

Хотите использовать Ваш новый современный диван, как кровать для сна на каждую ночь? Быстро трансформировать умный диван из стандартного положения в положение с комфортным спальным местом помогут фирменные надежные механизмы трансформации диванов. В зависимости от особенностей модели дивана, умный диван комплектуется подходящим механизмом трансформации:

«Дельфин» 5в1

Умный механизм трасформации «Дельфин» 5в1

Популярным механизмом трансформации «Дельфин» 5в1 комплектуется большинство умных диванов.

Данный механизм обладает повышенной надежностью, удобством раскладывания и умной функциональностью. Современный механизм трансформации «Дельфин» 5в1 позволяет Вам получить

5 положений спального места

различного размера и назначения от односпального гостевого до огромного на каждый день.

Современный механизм трансформации «Дельфин» 5в1 позволяет Вам получить

5 положений спального места

различного размера и назначения от односпального гостевого до огромного на каждый день.

«Дельфин» 3в1

Механизм трасформации для модели «IQ 122»

Надежный и удобный механизм трансформации «Дельфин» 3в1 позволяет Вам получить 3 положения спального места: односпальное, увеличенное односпальное за счет поднятых подушек, огромное спальное место для комфортного сна каждую ночь.

Практичный и современный механизм трансформации «Еврокнижка»

(также называют «Пантограф» или «Шагающая Еврокнижка»)

позволяет Вам получить комфортное спальное место на каждый день,

расположенное вдоль дивана. Это особенно ценно при ограниченном пространстве.

С механизмом «Еврокнижка» Вы можете полноценно использовать Ваш

новый умный диван даже в довольно узкой комнате.

Это особенно ценно при ограниченном пространстве.

С механизмом «Еврокнижка» Вы можете полноценно использовать Ваш

новый умный диван даже в довольно узкой комнате.

Механизмы трансформации

Главная/Механизмы трансформацииФабрика мягкой мебели «СОКРУЗ»

Механизм трансформации – раскладная часть дивана-кровати. Данная конструкция отвечает за то, каким образом будет организовано спальное место. Наша мебельная фабрика комплектует свои изделия всеми современными механизмами трансформации.

- «Спартак» – механизм трансформации отличается универсальностью, мобильностью и комфортом. Не имеет деревянных и пластиковых соединений. Механизм раскладывается в 3 шага. Используется поролоновый матрац толщиной 70 мм. «Спартак» может быть установлен даже в небольшие диваны. Изделие занимает немного места в сложенном состоянии, но обеспечивает максимальный комфорт во время сна. Эффект достигается благодаря оригинальной конструкции механизма и применению качественных металлических комплектующих повышенной прочности.

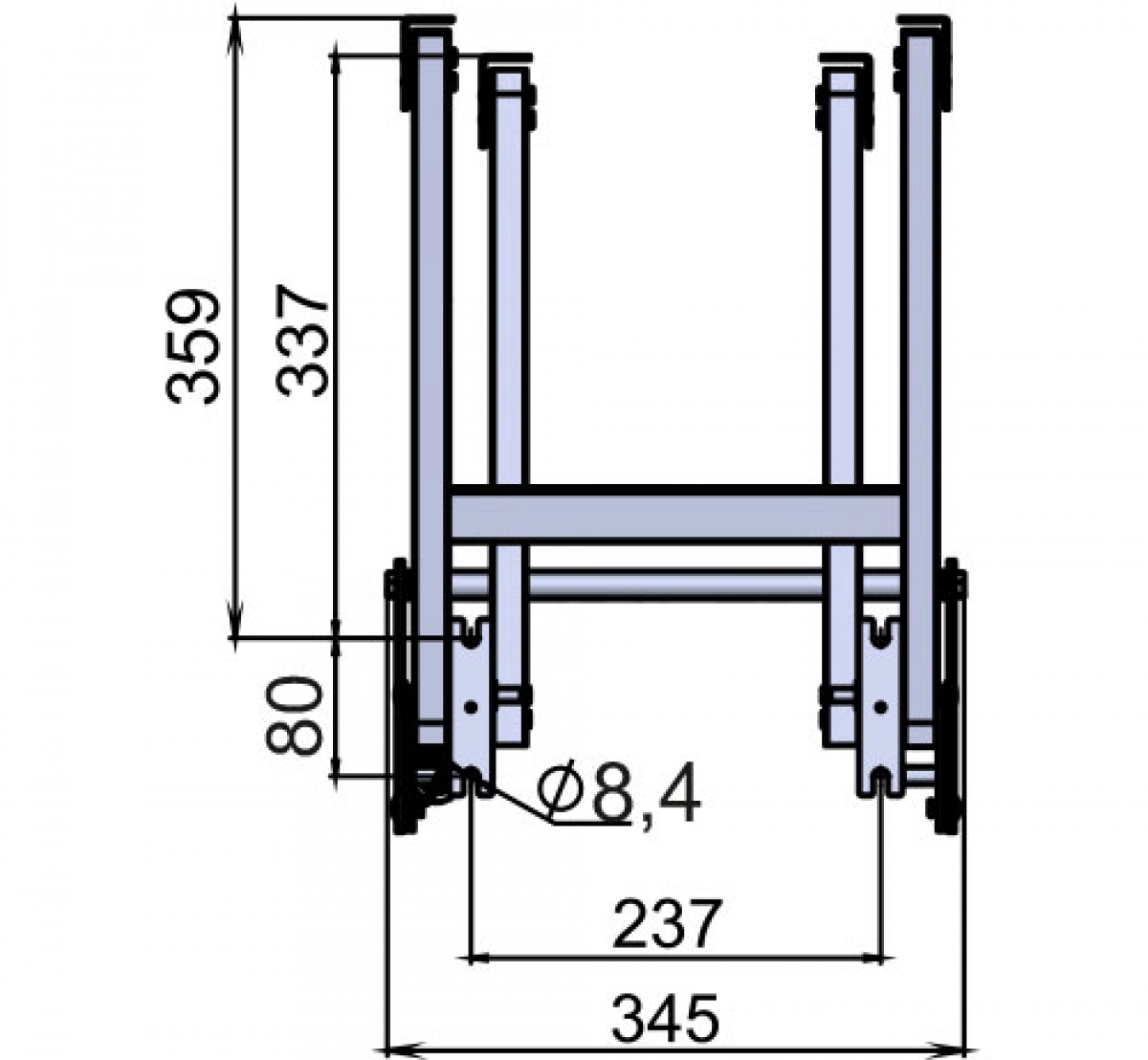

Каркас из высокопрочных стальных труб с порошковым покрытием. Толщина стенки трубы составляет 1,5 мм. Каркас усилен 2-мя поперечными элементами, которые обеспечивают жесткость и сохраняют геометрию изделия. Производится с металлической сварной сеткой из прутков стали. Способ установки позволяет быстро монтировать и демонтировать механизм трансформации. Механизм трансформации можно транспортировать отдельно от мебели.

Каркас из высокопрочных стальных труб с порошковым покрытием. Толщина стенки трубы составляет 1,5 мм. Каркас усилен 2-мя поперечными элементами, которые обеспечивают жесткость и сохраняют геометрию изделия. Производится с металлической сварной сеткой из прутков стали. Способ установки позволяет быстро монтировать и демонтировать механизм трансформации. Механизм трансформации можно транспортировать отдельно от мебели. - «Миксотойл» – механизм трансформации для гостевого варианта. Состоит из металлического каркаса, ортопедических лат, тента, пенополиуретанового матраца.

- «Дельфин» – механизм трансформации «на каждый день», надежный механизм, простой в использовании. Чтобы разложить диван, нужно всего лишь выдвинуть выкатную часть на себя, затем за петлю движение вверх и на себя поднять мягкий элемент выкатной части. Спальное место готово.

- «Выкатной» – механизм трансформации «на каждый день», простой в использовании.

Представляет собой смесь двух механизмов: «экспресс» – в начальной стадии раскладки и «дельфина». Выдвинуть выкатную часть на себя, затем за петлю движение вверх и на себя поднять мягкий элемент выкатной части.

Представляет собой смесь двух механизмов: «экспресс» – в начальной стадии раскладки и «дельфина». Выдвинуть выкатную часть на себя, затем за петлю движение вверх и на себя поднять мягкий элемент выкатной части. - «Пума» – механизм трансформации предназначен для ежедневного использования. Конструктивная особенность механизма «Пума» заключается в принципе его трансформации: при «раскладывании» сиденье не выкатывается по полу, а плавно приподнимается и встает на опоры. Это просто и удобно. Механизм снабжен синхронизирующим устройством, благодаря которому трансформация осуществляется легко.

- «Еврософа» – механизм трансформации предназначен для ежедневного использования. Выкатное сиденье и откидная спинка образуют ровное спальное место. Для более легкого перемещения при трансформации дивана в положение «кровать» выкатное сиденье имеет ролики с мягким синтетическим покрытием, не оставляющим царапин на полу.

- «Аккордеон» – механизм трансформации «на каждый день».

Основу механизма составляет металлический каркас, стальные рамы и ортопедические латы из гнутоклеенной березы. Чтобы разложить диван, нужно всего лишь выдвинуть выкатную часть за царгу на себя и спальное место готово.

Основу механизма составляет металлический каркас, стальные рамы и ортопедические латы из гнутоклеенной березы. Чтобы разложить диван, нужно всего лишь выдвинуть выкатную часть за царгу на себя и спальное место готово. - «Клик-клак» – механизм трансформации «на каждый день». Механизм трансформации прост и надежен. Основа – стальные рамы, оснащенные ортопедическими латами из гнутоклеенной березы. «Клик-клак» имеет три уровня раскладывания: сидя, лежа и промежуточное положение для отдыха – «relax».

- «Книжка» – механизм трансформации «на каждый день», один из самых распространенных механизмов. Принцип действия прост. Сиденье поднимается до щелчка, затем опускается – при этом опускается и спинка. Образуется удобное спальное место. Чтобы сложить, необходимо снова поднять сиденье до щелчка и опустить – спинка вернется в вертикальное положение.

- «Тик-так» – механизм трансформации «на каждый день». Выталкиваем сиденье наверх и вперед, после чего необходимо опустить спинку на освободившееся место.

Перемещаемое «перешагивает» требуемое для раскладывания расстояние, не задевая напольное покрытие. Диван можно разложить одной рукой. Механизм трансформации не требует приложения значительных усилий, надежен и бесшумен

Перемещаемое «перешагивает» требуемое для раскладывания расстояние, не задевая напольное покрытие. Диван можно разложить одной рукой. Механизм трансформации не требует приложения значительных усилий, надежен и бесшумен

Фабрика мягкой мебели «Rivalli»

- 1. Механизм «Отелло Н-18»

Механизм премиум класса предназначен для ежедневного использования и рассчитан на многолетнюю эксплуатацию. Благодаря механизму трансформации не нужно убирать подушки с дивана, он легко складывается и раскладывается.

Используется при изготовлении моделей: «Шеффилд» прямой диван, «Шеффилд» угловой диван

• Длина спального места 2000 мм.

• Эластичные ремни, интегрированные в изножье механизма, обеспечивают более комфортное место для сидения на диване, смягчая его поверхность.

• Механизм может комплектоваться Пружинным матрасом толщиной 140 мм, ППУ матрасом, толщиной 130 мм, либо НПБ матрасом, толщиной 140 мм.

• Толщина механизма с открученной спинкой всего 460 мм, что дает возможность занести его в любой дверной проем.

- 2. Механизм «Высоковыкатной»

Высоковыкатной, трехсекционный механизм учитывает пожелания в области создания эргономического,технологического, компактного при транспортировке и удобного при сборке дивана.

Рамка секции сиденья комплектуется би-латами, обеспечивающими наиболее комфортную посадку на диван. Остальные рамки выполнены с применением мебельной электросварной металлической сетки, обеспечивающей достаточный комфорт и надежность механизма.

Используется при изготовлении моделей: «Фернандо» прямой диван, «Фернандо» модульный диван

- Подлокотники дивана устанавливаются на основание механизма с применением быстроразъемного соединения типа «Байонет».

- Уникальная простота и легкость трансформации достигается за счет оптимального баланса кинематики механизма.

- Конструкция изголовья обеспечивает отсутствие разнотолщинности настилов в плечевой зоне в положении «кровать», что благоприятно сказывается на комфортности отдыха.

- 3.Механизм «Аккордеон ГРИД»

Слово «грид», в переводе с английского языка, означает просто-напросто сетку. Так что «Аккордеон Грид» с замком АТС – это знакомый всем механизм, но с новшествами, повышающими его потребительские свойства. В частности – с сеткой в секции сиденья.

Усовершенствование делалось с учетом сохранения внешних габаритов механизма, так что внедрение моделей на новом механизме проводится без изменения размеров и внешнего вида изделий. Это позволяет проводить быструю модернизацию модельного ряда.

Используется при изготовлении моделей с шириной механизма 70, 80, 120, 140, 155, 180, 195 см: «Дублин», «Кельн», «Нова», «Паскаль», «Пегас», «Турин», «Феникс», «Чикаго», «Шервуд»

- Применение мебельной металлической сетки в секции сиденья существенно улучшает эксплуатационные качества механизма и исключает поломку, даже если на сиденье дивана в сложенном состоянии встать ногами или если дети захотят превратить диван в батут.

- Усиленная конструкция рамки позволяет использовать в диване более плотные наполнители. Расположение длинных поперечных лат усиливает ортопедический эффект спального места.

- Применение металлической сетки в рамке сиденья позволило переработать способ крепления задней опоры и полностью исключить возможность её излома при складывании-раскладывании механизма, даже в случае использования в качестве наполнителя очень тяжелых материалов (например, блоки независимых пружин).

- Замок АТС Грид имеет больший угол раскрытия, нежели обычный АТС, обеспечивая еще более удобный доступ к бельевому ящику

- 4. Механизм «Аккордеон МЕККАНО»

Уникальная, запатентованная система крепления мебельной змейки к металлическому каркасу с помощью упорных змейкодержателей позволила создать механизм . Теперь появилась возможность изготовить диван на механизме типа Аккордеон с необычайно комфортным местом для сидения.

Используется при изготовлении моделей с шириной механизма 70, 80, 120, 140, 155, 180, 195 см: Бристоль, Сиенна

- Механизм состоит из трех секций.

Головная секция подвижно закреплена на цокольной опоре, и все три секции связаны между собой с помощью петель и уникального замка АТС.

Головная секция подвижно закреплена на цокольной опоре, и все три секции связаны между собой с помощью петель и уникального замка АТС. - Обновленная конструкция замка АТС NEXT позволяет значительно увеличить угол раскрытия механизма для еще более удобного доступа к бельевому ящику и значительно снижает усилие складывания дивана.

- Применение мебельной змейки в рамке сидения позволяет теперь создать на базе механизма Аккордеон диван с уникально комфортным местом для сидения.

- Усиленная конструкция рамки позволяет использовать в диване более плотные наполнители. Расположение длинных поперечных лат усиливает ортопедический эффект спального места.

- Применение мебельной змейки в рамке сиденья позволило переработать способ крепления задней опорной ноги и полностью исключить возможность её излома при складывании-раскладывании механизма, даже в случае использования в качестве наполнителя очень тяжелых материалов (например, блоки независимых пружин).

- Применение дополнительных опорных кронштейнов позволило усилить среднюю рамку механизма в положении кровать за счет создания четырех точек опоры для нее. Данное усовершенствование, во-первых, полностью исключает возникновение скрипов в механизме во время эксплуатации дивана, во-вторых, снимает нагрузку с петель механизма, исключая вероятность их «разбалтывания», в-третьих, улучшает горизонтальность механизма в положении кровать, исключая «проседание» средней секции в процессе эксплуатации.

- 5. Механизм «Пантограф»

Механизм «Пантограф» на базе рамки «Сандра» представляет собой металлокаркасную конструкцию, состоящую из рамы сиденья и рамы спинки, изготовленных из профиля 30х20 мм с применением электросварной металлической сетки и разборного каркаса основания.

Позволяет изготовить надежный, стильный и комфортный диван-кровать, который легко трансформируется в полноценное спальное место.

Используется при изготовлении моделей: «Ванкувер», «Лайф», «Мадрид», «Манхэттен», «Манчестер», «Монако», «Ницца», «Орландо», «Пикассо», «Сиэтл», «Хьюстон»

- Все несущие рамки имеют дополнительные элементы опоры для увеличения устойчивости конструкции к деформациям при значительных нагрузках с течением времени

- Механизм предназначен для изготовления диванов с применением запатентованной без обивочной технологии, что делает чехлы таких диванов легко съемными и заменяемыми

- Конструкция рамок основания позволяет проектировать диваны с размером спального места 150х205 см (полноценная двуспальная кровать)

- В основании матраса – специализированная мебельная металлическая сетка.

Обеспечивает упругость и жесткость – это дает комфорт при отдыхе и увеличивает срок службы изделия (предотвращает быструю деформацию матраса)

Обеспечивает упругость и жесткость – это дает комфорт при отдыхе и увеличивает срок службы изделия (предотвращает быструю деформацию матраса)

- Надежный механизм «Пантограф» с компенсационными пружинами делает процесс сложения/разложения легким и удобным.

- Супер легкая и быстрая сборка – подлокотники и спинка крепятся с помощью системы байонетов. Никакого инструмента не потребуется!

- 6. Механизм «Клик-Кляк» («Книжка»)

Классическая «книжка» на базе механизма «Банкетка Форте». Банкетка представляет собой хорошо отработанный, традиционный механизм типа «книжка». На сегодняшний день это один из самых популярных механизмов трансформации. Обеспечивает ровную спальную поверхность. Используется при изготовлении моделей «Баккара», «Милан»

- Конструкция рамок основания позволяет проектировать диваны с размером спального места 140х210 см (полноценная двуспальная кровать) с очень толстым матрасом (16см)

- Расположение длинных поперечных лат усиливает ортопедический эффект спального места.

Латодержатели упорного типа увеличивают срок службы матраса, создавая ровную поверхность с каркасом механизма.

Латодержатели упорного типа увеличивают срок службы матраса, создавая ровную поверхность с каркасом механизма.

- Дополнительная связь посередине способствует увеличению нагрузки на спальное место до 120 килограмм, значительно продлевая срок эксплуатации по сравнению со стандартными рамками

- Три положения для отдыха «кровать», «диван», «релакс» обеспечиваются замком NSM (замок обладает уникальными характеристиками прочности и жесткости при небольших размерах).

- Специальное инженерное решение в проектировании замка позволило добиться того, что в случае неправильной трансформации (под нагрузкой) детали NSM берут на себя основную часть нагрузки. Так что в случае поломки, потребуется заменить только замок, а не детали дивана, что существенно проще и дешевле. Заменить такой замок можно самостоятельно в домашних условиях.

- 7. Механизм «Откатной Клик-Кляк»

Ключевой особенностью этого механизма является особый замок, позволяющий раскладывать диван, не отодвигая от стены. Конструкция дает возможность использовать на спинке и сидении полноценный ортопедический матрас. Есть возможность предусмотреть вместительный ящик для белья. Используется при изготовлении моделей «Верона»

Конструкция дает возможность использовать на спинке и сидении полноценный ортопедический матрас. Есть возможность предусмотреть вместительный ящик для белья. Используется при изготовлении моделей «Верона»

- Конструкция рамок основания позволяет проектировать диваны с размером спального места 140х210 см (полноценная двуспальная кровать) с очень толстым матрасом (16см)

- Расположение длинных поперечных лат усиливает ортопедический эффект спального места. Латодержатели упорного типа увеличивают срок службы матраса, создавая ровную поверхность с каркасом механизма.

- Механизм комплектуется замком 3015 производства Sedac Meral Бельгия.

- Прочность конструкции значительно повышена за счет цоколя.

- Не нужно отодвигать от стены!

- 8. Механизм «Клик-Кляк»

с подлокотниками-трансформерами«Клик-кляк» на базе рамки Арджента Ретта Компатта представляет собой компактный механизм, позволяющий интегрировать в конечное изделие вместительный ящик для белья.

Механизм в положении кровать представляет собой идеально ровную спальную поверхность. Благодаря четырем складываемым независимо подлокотникам, дает возможность каждому выбрать индивидуальное положение для отдыха.

Используется при изготовлении модели «Руана»

- Конструкция рамок основания позволяет проектировать диваны с размером спального места 140х210 см (полноценная двуспальная кровать) с очень толстым матрасом (16см)

- Длинные поперечные латы усиливают ортопедический эффект спального места, увеличивают срок службы матраса, создавая ровную поверхность с каркасом механизма.

- Все подлокотники съемные, что дает высокую ремонтопригодность и меньший риск повреждения при транспортировке и хранении. Имеют 5 положений сложения.

- Три положения для отдыха «кровать», «диван», «релакс» обеспечиваются замком NSM (замок обладает уникальными характеристиками прочности и жесткости при небольших размерах).

- Специальное инженерное решение в проектировании замка позволило добиться того, что в случае неправильной трансформации (под нагрузкой) детали NSM берут на себя основную часть нагрузки. Так что в случае поломки, потребуется заменить только замок, а не детали дивана, что существенно проще и дешевле. Заменить такой замок можно самостоятельно в домашних условиях.

- 9. Механизм «Дельфин»

Цельнометаллический каркас «Просперо» в сочетании с механизмом трансформации «Дельфин» позволяют создать комфортный и удобный угловой диван с открывающейся оттоманкой, огромным ящиком для белья, выкатным механизмом спального места и стильным подлокотником. Данный механизм позволяет создавать систему модульных диванов. Конструкция механизма предусматривает смену положений оттоманки и подлокотников. Все элементы модулей соединяются между собой при помощи быстроразъемных зацепов байонет.

Используется при изготовлении угловых моделей: «Ванкувер», «Манхэттен», «Монако», «Орландо»

- Размер спального места 145х190 см

- Основанием спального места является мебельная сварная металлическая сетка, обеспечивающая достаточный комфорт и необыкновенную надежность механизма.

- Оттоманка с углом подъема 60 градусов обеспечивает удобный доступ к бельевому ящику.

- Металлический каркас дивана, выполненный из высокопрочных стальных труб, гарантирует соблюдение геометрии дивана на весь срок его службы и корректную и мягкую работу механизмов выдвижения и подъема.Надежные зацепы типа байонет позволяют быстро и легко соединить/разъединить элементы дивана, делая угловые модели универсальными

- 10. Механизм «Лит»

Кушетка «Лит» представляет собой компактный диванчик для студии или детской комнаты. Она отличается небольшой массой, что особенно важно в производстве мебели нового поколения. В разложенном состоянии кушетка образует идеальное ровное место, рассчитанное на одного человека.

Используется при изготовлении модели «Джимми»

- Модель «Лит» имеет подлокотники с максимальными углами подъема 90 градусов и четырьмя фиксирующимися положениями.

- Удобные подлокотники легко складываются или раскладываются, что позволяет подобрать идеальное положение индивидуально для каждого

- Высочайшая надежность металлической конструкции обеспечит долговечность и безотказность службы дивана

- Полноценное спальное место для одного человека, взрослого или ребенка

- 11. Механизм «Серджио»

Оригинальный механизм кресла-кроватей на базе металлического каркаса «Серджио». Позволяет получить кресло, которое легко и мягко трансформируется в односпальную кровать. Запатентованная разработка. Не имеет аналогов по простоте и надежности. Используется при изготовлении моделей: «Ванкувер», «Манхэттен», «Монако», «Ницца», «Пикассо», «Хьюстон», «Орландо»

- Благодаря особенностям конструкции, можно использовать целый матрас, без промежутков и швов (кроме ножной секции, где это не существенно)

- Комфортное спальное место — длина в разложенном состоянии 2 метра! (1, 97 см)

- Матрас толщиной как у дивана-кровати — 100 мм.

Уникальная кинематика механизма делает процесс трансформации необыкновенно легким, а также позволяет избегать контакта элементов кресла с полом или ковролином в момент раскладывания.

Уникальная кинематика механизма делает процесс трансформации необыкновенно легким, а также позволяет избегать контакта элементов кресла с полом или ковролином в момент раскладывания. - В основании матраса – специализированная мебельная металлическая сетка. Обеспечивает упругость и жесткость – это дает комфорт при отдыхе и увеличивает срок службы изделия (предотвращает быструю деформацию матраса)

- Супер легкая и быстрая сборка – подлокотники и спинка крепятся с помощью системы байонетов. Никакого инструмента не потребуется!

- На задней части каркаса предусмотрены колесики – передвинуть кресло можно быстро и без труда, исключая возможность поцарапать пол или оставить отметины на дорогом ковре.

- 12.Кресло на металлокаркасе

Кресла на металлокаркасе легкие, комфортные и надежные. Срок эксплуатации таких изделий очень высокий, сборка простая и удобная. Использование металлокаркаса позволяет интегрировать удобный выкатной бельевой ящик, который полностью выдвигается, облегчая доступ к вещам и при уборке.

Используется при изготовлении моделей: «Ванкувер», «Манхэттен», «Ницца», «Орландо», «Пикассо», «Хьюстон», «Монако»

- Надежный долговечный металлокаркас

- Простая замена чехлов

- Высокая ремонтопригодность

- Бельевой ящик выдвигается полностью

- Удобная быстрая сборка на байонетах

Механизмы трансформации для диванов и кроватей.

Любые механизмы трансформации диванов в Екатеринбурге можно купить в нашей компании.Возможна доставка транспортной компанией по России.

Внимание!!!

В нашей компании есть любой механизм, если Вы не нашли деталь на сайте, позвоните для уточнения.

На странице:12244896

Механизмы под заказ

Если Вы не нашли нужную запчасть, выберите данный раздел. Можете отправить нам фото на почту.

1500 руб

Механизм подъема кровати 503

Механизм подъема кровати. Угол подъема 36 или 43 градуса, в зависимости от длинны газлифта. Цена за комплект.

1600 руб

Механизм подъема 502

Механизм для кровати. Удобный доступ к бельевому ящику. Угол подъема 57 градусов. Комплектуется газлифтами отдельно. Цена за комплект.

1600 руб

Механизм подъема Летто 142

Механизм для подъема кровати с использованием газлифтов. Угол подъема 40°. Газлифты приобретаются отдельно.

1700 руб

Механизм подъема 556

Увеличенный угол подъема при небольших размерах механизма. Цена за комплект.

1500 руб

Механизм 150-1

Механизм имеет три положения (сидя, полусидя, лёжа)

1500 руб

Механизм 542

Механизм для поднятия подлокотника, который имеет несколько положений. Цена за комплект.

600 руб

Механизм 403

Механизм подъема обеспечивает удобный доступ к бельевому ящику. В комплекте механизма идет 4 пружины

1500 руб

Механизм Цинк

Механизм для диванов Аккордеон на деревянном основании.

1700 руб

Замок NSM для механизма Клик Кляк (Цинк)

Замок для дивана «Клик-кляк» фиксируется внутри ящика для белья. Имеет положения — сидя, полусидя и лежа. Изготовлен из стали 3 мм. В отличие от крашенного замка имеет свойство оставлять следы трения в коробе дивана в виде металлической крошки. Цена за ко

1500 руб

Механизм Трансформации 320

Используется для диванов типа Клик кляк. Механизм более мощный, позволяет использовать тяжелые и высокие матрасы. Цена указана за комплект.

3000 руб

Механизм КБ 605

Механизм используется в корпусной мебели. Небольшой механизм может удерживать до 20 кг динамической нагрузки. Цена указана за комплект.

500 руб

Микролифт 524

Используется для подъема сидения на кухонных уголках. На данном механизме не стоят пружины. Угол подъема 90 градусов.

500 руб

Механизм трещетка

Используется для подъема спинки дивана с зафиксированным местом для сидения.

2100 руб

Механизм Дельфин 126

Серия Дельфин, размер большой.Требует изготовления выкатного короба. За счет своего размера можно увеличить спальное место.

1400 руб

Механизм крокодил

Материал сталь. Механизм для зацепа двух деталей и притяжения к друг другу.

500 руб

Механизм дельфин 413

Механизм для дивана типа «Дельфин». Классический вариант удобства и простоты. Усиленный механизм без стопора.

1500 руб

Механизм Венеция 405

Механизм Венеция 405 для выкатных диванов. Не требует изготовления выкатного короба.

1600 руб

Замок АТС Россия

Замок АТС обеспечивает свободный доступ к бельевому ящику, фиксируя сидение в верхнем положении, и дает возможность, не собирая диван, опустить рамку в исходное положение.

800 руб

Механизм для подъема тахты №509

В комплект входит правая, левая сторона механизма и две пружины. Если требуются дополнительные пружины, укажите это в комментарии к заказу.

1300 руб

Механизм Пума 578

Механизм трансформации дивана, шагающий «Пума» №578. В комплекте правый и левый механизм и пружины, цвет серый.

2900 руб

Механизм 290

Одна из разновидностей механизмов «книжка». Используется на деревянных каркасах.

1300 руб

Механизм Юниор

Механизм Юниор позволяет с легкостью трансформировать кресло в спальное место. Раскладывание происходит вытягиванием сиденья на себя и спинка ложится на место сиденья.

1600 руб

Мелкие запчасти

Если интересуют мелкие запчасти перейдите на вкладку «Мелкие запчасти для диванов и кроватей»

100 руб

Если Вы не нашли нужный механизм, позвоните нам и мы поможем!!!

8-800-350-43-09 (Звонок по России бесплатный)

Механизмы трансформации диванов бывают разных видов, это может быть механизм поворота, «Змейка», «Финка», «Еврокнижка», роликовые опоры, штыри, петли, зацепы, классический «Дельфин», «Венеция», «Версаль», «Тик-так», «Пума», «Пантограф», «Аккордеон», «Клик-Кляк», уголок опорный. Так же в наличии есть газлифты для кровати.

Если Вы собрались сделать двуспальную кровать с подъемным механизмом своими руками, то идеальным механизмом для кровати будет №503, если вес кровати до 80 кг вместе с матрасом, то потребуются газлифты на 800 N.

Механизмы трансформации диванов – выкатные, раскладывающиеся диваны и не только

Механизмы трансформации диванов

Существуют много критериев оценки удобства дивана. В этой статье мы рассмотрим функциональность, а именно какие способы раскладки диванов существуют, достоинства и недостатки, на что стоит обратить внимание при покупке.

Вначале определимся, что такое механизм трансформации дивана. Часто используют и другое название — механизм раскладывания дивана.

Под этими названиями скрывается элемент , который преобразует диван в различные формы и положения. Например, диван из сидячего положения превращается в диван-кровать или в диван для «релакса» с частично откинутой спинкой.

По принципу действия все механизмы трансформации диванов можно условно разделить на три группы: раскладные, выкатные, и разворачивающиеся (диваны-раскладушки).

Раскладные диваны

Название раскладных диванов говорит само за себя: они именно раскладываются. К ним относятся такие механизмы трансформации как «Книжка», «Клик кляк». Раскладывающиеся диваны компактны и способны удачно вписаться даже в небольшое помещение.

Книжка

В разложенном состоянии диван напоминает раскрытую книгу — отсюда и название. «Книжка» имеет два положения: для сидения и для сна. Снизу есть вместительный ящик для белья. Единственный недостаток такой конструкции — стоящий у стены диван нужно слегка отодвинуть, чтобы разложить.

Клик-кляк

«Клик-кляк» — тоже диван-книжка, но имеющий некоторые конструктивные особенности. Название он получил из-за характерного звука, который механизм издает при трансформации. В отличие от «книжки», диван имеет три положения: разложенное, сидячее и промежуточное, которое называют «релакс». Хорош и для сна, и для отдыха. Большинство моделей имеют ящик для белья.

Выкатные диваны

И здесь всё понятно: чтобы разложить диван, необходимо потянуть и выкатить его основание.

Еврокнижка

Еврокнижка — простой, долговечный и надежный механизм. Раскладывается очень просто: нижняя часть дивана выкатывается вперед на роликах по направляющим, а спинка укладывается на освободившееся место. Диван идеален для ежедневного сна: спальное место получается большим и ровным. Поднятая спинка открывает вместительный бельевой ящик. Особый плюс — диван не нужно отодвигать от стены для того, чтобы разложить.

Тик-так

«Тик-так» — та же самая «еврокнижка», только нижняя часть не выкатывается на роликах, а слегка приподнимается, вытягивается на себя с помощью пружинного механизма и ставится на пол. Такая конструкция не царапает пол и не оставляет следов на покрытии.

Дельфин

У диванов с механизмами «Дельфин»под основным сиденьем скрывается дополнительный потайной блок. Именно его мы вытягиваем и поднимаем до уровня основного сиденья, чтобы получить кровать. В разложенном виде получается просторное спальное место. Из недостатков — в прямых версиях диванов нет ящиков для белья.

Тройной трансформер

Механизм Тройной трансформер считается самым прочным механизмом, т.к. рассчитан на частые трансформации, на ежедневное использование.

Выкатной механизм трансформации состоит из трех частей. В упакованном виде передняя часть механизма находится в спинке дивана, и выдвигается на место головы во время трансформации.

Средняя часть механизма в упакованном виде находится под подушкой. Самая же первая часть механизма, на которую после трансформации ложатся ваши ноги, представляет собой рамочную конструкцию и в упакованном виде находится во внешней стороне средней части.

Механизм приводится в действие выдвижением как раз этой передней части, которая тянет за собой остальные две части с помощью системы роликов и кронштейнов.

Диваны-раскладушки

Здесь всё просто: внутри дивана, под его сиденьем, прячется настоящая раскладушка. Вся разница только в том, как она вынимается и раскладывается.

Аккордеон

Просто, надежно и оригинально — так можно описать механизм «Аккордеон». Спальное место получается ровным и удобным, а простой механизм позволяет раскладывать диван-аккордеон ежедневно в течение долгого времени. Для того, чтобы разложить диван, достаточно слегка поднять и потянуть на себя сиденье. Диван выпрямляется и превращается в удобную кровать.

Французская раскладушка (Спартак)

В французской раскладушке под сиденьем спрятана обыкновенная, сложенная втрое, раскладушка. Для того, чтобы извлечь и раскрыть ее, необходимо убрать с дивана подушки и само сиденье, после чего слегка потянуть на себя и разложить. Конструкция проста и надежна.

Спартак — по сути, это более прочная французская раскладушка, дополненная сварной металлической решеткой. Такой вид раскладывания диванов совместно разработали российские и итальянские мастера. Такая мебель очень хорошо подходит для сна. Конструкция механизма обеспечивает длинное спальное место.

Седафлекс (Американская раскладушка)

Внутри дивана спрятана двойная раскладная конструкция с ортопедическим матрасом. Толстый матрас сглаживает неровности и сочленения, поэтому на таком диване можно спать ежедневно. Минус — негде хранить постельное бельё, на ночь необходимо убирать подушки и сиденья.

Что выбрать?

В качестве итога можно определить, чем хорош каждый механизм и о чем следует помнить при выборе:

Книжка — низкая цена, быстрым способом раскладывания, вместительный ящик для белья. Расстояние от спинки до стены должно быть не менее 10 см., для раскладывания необходимо приложить усилия.

Клик-кляк — компактность, комфортабельное спальное место, за счёт использования ламелей получается ортопедический эффект, можно отрегулировать подлокотники под индивидуальные потребности. Диван нельзя прислонять близко к стене, спальное место располагается там же, где и место для сидения.

Еврокнижка — наиболее надёжный механизм, вместительный ящик для белья, нет необходимости двигать диван каждый раз при раскладывании, подходит для узких комнат. Модели без колес могут царапать пол.

Тик-так (пума, пантограф) — не взаимодействует с полом, оснащен бельевым отсеком, не нужно двигать при раскладывании. Для раскладывания требуется приложить больше усилий, чем в «еврокнижке».

Дельфин — самый просторный, легкость в раскладке. Нет ящика для хранения белья.

Тройной трансформер (ТТ) — надёжный механизм, можно использовать ежедневно, компактный объём, есть ящик для белья, комфортно спать. Диван очень тяжёлый сам по себе из-за массивного механизма, но раскладывать его не сложно.

Аккордеон — надёжный и устойчивый механизм, продолжительный срок службы дивана, лёгкость трансформации. Нет встроенного места для белья, выкатной тип механизма может стать причиной царапин на напольном покрытии.

Французская раскладушка (Спартак) — прочность и долговечность механизма, лёгкость в использовании, в качестве кровати можно использовать часто, удобное спальное место. Нет места для хранения белья, прежде, чем разложить диван, с него нужно убрать подушки.

Седафлекс (Американская раскладушка) — очень удобный механизм, очень компактный, удобный качественный толстый матрас. Нет ящика для вещей.

При покупке любого дивана обязательно осматривайте его механизм раскладывания, консультируйтесь по этому поводу с продавцом, задавайте вопросы и требуйте на них ответы.

От правильного механизма очень сильно зависит срок службы дивана и удобство его использования. Если диван будет раскладываться редко, то стоит обратить внимание на модели компактные, но не предназначенные для частой трансформации.

The Illustrated Transformer — Джей Аламмар — Визуализация машинного обучения по одной концепции за раз.

Обсуждения:

Hacker News (65 баллов, 4 комментария), Reddit r / MachineLearning (29 баллов, 3 комментария)

Переводы: Испанский, Китайский (упрощенный), Корейский, Русский, Китайский (Упрощенный), Французский, Японский

Смотреть: лекция MIT по теме «Глубокое обучение», ссылка на которую имеется в этой публикации

В предыдущем посте мы рассмотрели «Внимание» — повсеместный метод в современных моделях глубокого обучения.Внимание — это концепция, которая помогла повысить производительность приложений нейронного машинного перевода. В этом посте мы рассмотрим The Transformer — модель, которая привлекает внимание для повышения скорости обучения этих моделей. Трансформеры превосходят модель нейронного машинного перевода Google в определенных задачах. Однако самое большое преимущество заключается в том, что The Transformer поддается распараллеливанию. Фактически, Google Cloud рекомендует использовать The Transformer в качестве эталонной модели для использования своего предложения Cloud TPU.Итак, давайте попробуем разбить модель на части и посмотрим, как она работает.

Трансформатор был предложен в статье «Внимание — это все, что вам нужно». Его реализация в TensorFlow доступна как часть пакета Tensor2Tensor. Группа НЛП из Гарварда создала руководство с аннотациями к статье с использованием PyTorch. В этом посте мы попытаемся немного упростить вещи и представить концепции одну за другой, чтобы, надеюсь, облегчить понимание людям без глубоких знаний предмета.

2020 Обновление : Я создал видео «Рассказанный трансформер», в котором более мягкий подход к теме:

Взгляд высокого уровня

Давайте начнем с рассмотрения модели как единого черного ящика. В приложении машинного перевода оно берет предложение на одном языке и выводит его перевод на другом.

Раскрывая эту доброту Оптимуса Прайма, мы видим компонент кодирования, компонент декодирования и связи между ними.

Компонент кодирования представляет собой стек кодировщиков (на бумаге шесть из них складываются друг на друга — в числе шесть нет ничего волшебного, можно определенно поэкспериментировать с другими компоновками). Компонент декодирования представляет собой стек декодеров с одинаковым числом.

Все кодировщики идентичны по структуре (но у них нет общих весов). Каждый из них разбит на два подслоя:

Входные данные кодировщика сначала проходят через слой самовнимания — слой, который помогает кодировщику смотреть на другие слова во входном предложении, когда он кодирует определенное слово.Позже мы подробнее рассмотрим самовнимание.

Выходные данные слоя самовнимания передаются в нейронную сеть с прямой связью. Точно такая же сеть прямой связи независимо применяется к каждой позиции.

В декодере есть оба этих уровня, но между ними есть уровень внимания, который помогает декодеру сосредоточиться на соответствующих частях входного предложения (аналогично тому, что делает внимание в моделях seq2seq).

Использование тензоров в картине

Теперь, когда мы рассмотрели основные компоненты модели, давайте приступим к рассмотрению различных векторов / тензоров и того, как они перемещаются между этими компонентами, чтобы превратить входные данные обученной модели в выходные данные.

Как и в случае с приложениями НЛП в целом, мы начинаем с превращения каждого входного слова в вектор с помощью алгоритма встраивания.

Каждое слово вложено в вектор размером 512. Мы представим эти векторы этими простыми прямоугольниками.

Встраивание происходит только в самый нижний кодировщик. Абстракция, которая является общей для всех кодировщиков, заключается в том, что они получают список векторов, каждый из которых имеет размер 512. В нижнем кодировщике это будет слово embeddings, но в других кодировщиках это будет выход кодировщика, который находится непосредственно под .Размер этого списка — это гиперпараметр, который мы можем установить — в основном это будет длина самого длинного предложения в нашем наборе обучающих данных.

После встраивания слов в нашу входную последовательность каждое из них проходит через каждый из двух уровней кодировщика.

Здесь мы начинаем видеть одно ключевое свойство преобразователя, а именно то, что слово в каждой позиции проходит свой собственный путь в кодировщике. Между этими путями на уровне самовнимания есть зависимости.Однако уровень прямой связи не имеет этих зависимостей, и, таким образом, различные пути могут выполняться параллельно при прохождении через слой прямой связи.

Затем мы заменим пример более коротким предложением и посмотрим, что происходит на каждом подуровне кодировщика.

Теперь мы кодируем!

Как мы уже упоминали, кодировщик получает на вход список векторов. Он обрабатывает этот список, передавая эти векторы в слой «самовнимания», затем в нейронную сеть с прямой связью, а затем отправляет выходные данные вверх следующему кодировщику.

Слово в каждой позиции проходит процесс самовнимания. Затем каждый из них проходит через нейронную сеть с прямой связью — точно такую же сеть с каждым вектором, проходящим через нее отдельно.

Самовнимание на высоком уровне

Не обманывайтесь, когда я использую слово «самовнимание», как будто это понятие должно быть знакомо каждому. Я лично никогда не сталкивался с этой концепцией до тех пор, пока не прочитал статью «Все, что вам нужно». Давайте разберемся, как это работает.

Скажем, следующее предложение является вводным предложением, которое мы хотим перевести:

” Животное не переходило улицу, потому что слишком устало ”

Что означает «оно» в этом предложении? Имеется в виду улица или животное? Это простой вопрос для человека, но не такой простой для алгоритма.

Когда модель обрабатывает слово «оно», самовнимание позволяет ей ассоциировать «это» с «животным».

По мере того, как модель обрабатывает каждое слово (каждую позицию во входной последовательности), самовнимание позволяет ей смотреть на другие позиции во входной последовательности в поисках подсказок, которые могут помочь улучшить кодирование этого слова.

Если вы знакомы с RNN, подумайте, как поддержание скрытого состояния позволяет RNN включать свое представление предыдущих слов / векторов, которые она обработала, с текущим, который она обрабатывает. Самовнимание — это метод, который Трансформер использует для «запекания» других релевантных слов в словах, которые мы обрабатываем в данный момент.

Поскольку мы кодируем слово «оно» в кодировщике №5 (верхний кодировщик в стеке), часть механизма внимания фокусировалась на «Животном» и запекла часть его представления в кодировке «оно».

Обязательно ознакомьтесь с записной книжкой Tensor2Tensor, где вы можете загрузить модель Transformer и изучить ее с помощью этой интерактивной визуализации.

Внимание к себе в деталях

Давайте сначала посмотрим, как вычислить самовнимание с помощью векторов, а затем перейдем к рассмотрению того, как это на самом деле реализовано — с помощью матриц.

Первый шаг при вычислении самовнимания — создать три вектора из каждого входного вектора кодировщика (в данном случае — вложение каждого слова).Итак, для каждого слова мы создаем вектор запроса, вектор ключа и вектор значения. Эти векторы создаются путем умножения вложения на три матрицы, которые мы обучили в процессе обучения.

Обратите внимание, что эти новые векторы меньше по размерности, чем вектор внедрения. Их размерность составляет 64, в то время как векторы ввода / вывода встраивания и кодировщика имеют размерность 512. Они НЕ ДОЛЖНЫ быть меньше, это выбор архитектуры, позволяющий сделать вычисление многогранного внимания (в основном) постоянным.

Умножение x1 на весовую матрицу WQ дает q1, вектор «запроса», связанный с этим словом. В итоге мы создаем проекцию «запроса», «ключа» и «значения» для каждого слова во входном предложении.

Что такое векторы «запроса», «ключа» и «значения»?

Это абстракции, которые полезны для вычисления внимания и размышления о нем. После того, как вы перейдете к прочтению того, как рассчитывается внимание ниже, вы будете знать почти все, что вам нужно знать о роли каждого из этих векторов.

Второй шаг в вычислении самовнимания — это подсчет баллов. Предположим, мы рассчитываем самовнимание для первого слова в этом примере «Мышление». Нам нужно сопоставить каждое слово входного предложения с этим словом. Оценка определяет, сколько внимания следует уделять другим частям входного предложения, когда мы кодируем слово в определенной позиции.

Оценка рассчитывается как скалярное произведение вектора запроса на ключевой вектор соответствующего слова, которое мы оцениваем.Итак, если мы обрабатываем самовнимание для слова в позиции №1, первая оценка будет скалярным произведением q1 и k1. Вторая оценка будет скалярным произведением q1 и k2.

Третий и четвертый этапы заключаются в разделении оценок на 8 (квадратный корень из размерности ключевых векторов, используемых в статье — 64. Это приводит к получению более стабильных градиентов. Здесь могут быть и другие возможные значения, но это значение по умолчанию), затем передайте результат через операцию softmax.Softmax нормализует оценки, чтобы все они были положительными и в сумме составляли 1.

.Эта оценка softmax определяет, насколько каждое слово будет выражено в этой позиции. Очевидно, что слово в этой позиции будет иметь наивысший балл softmax, но иногда полезно обратить внимание на другое слово, имеющее отношение к текущему слову.

Пятый шаг — это умножение каждого вектора значений на оценку softmax (при подготовке к их суммированию). Интуиция здесь состоит в том, чтобы сохранить неизменными значения слов, на которых мы хотим сосредоточиться, и заглушить не относящиеся к делу слова (умножив их на крошечные числа, такие как 0.001, например).

Шестой этап заключается в суммировании векторов взвешенных значений. Это дает результат слоя самовнимания в этой позиции (для первого слова).

На этом расчет самовнимания завершен. Результирующий вектор — это тот, который мы можем отправить в нейронную сеть с прямой связью. Однако в реальной реализации этот расчет выполняется в матричной форме для более быстрой обработки. Итак, давайте посмотрим на это теперь, когда мы увидели интуицию вычисления на уровне слов.

Матрица расчета самовнимания

Первым шагом является вычисление матриц запроса, ключа и значения. Мы делаем это, упаковывая наши вложения в матрицу X и умножая ее на матрицы весов, которые мы обучили (WQ, WK, WV).

Каждая строка в матрице X соответствует слову во входном предложении. Мы снова видим разницу в размере вектора встраивания (512 или 4 прямоугольника на рисунке) и векторов q / k / v (64 или 3 прямоугольника на рисунке).

Наконец, , поскольку мы имеем дело с матрицами, мы можем объединить шаги со второго по шестой в одну формулу для вычисления выходных данных слоя самовнимания.

Расчет самовнимания в матричной форме

Многоголовый зверь

В статье дополнительно усовершенствован слой самовнимания, добавлен механизм, называемый «многоголовым» вниманием. Это улучшает производительность слоя внимания двумя способами:

Расширяет способность модели фокусироваться на разных позициях. Да, в приведенном выше примере z1 содержит немного любой другой кодировки, но в ней может преобладать само слово.Было бы полезно, если бы мы переводили предложение вроде «Животное не перешло улицу, потому что оно слишком устало», мы хотели бы знать, к какому слову «оно» относится.

Он дает слою внимания несколько «подпространств представления». Как мы увидим далее, с многоголовым вниманием у нас есть не только один, но и несколько наборов весовых матриц запроса / ключа / значения (преобразователь использует восемь головок внимания, поэтому мы получаем восемь наборов для каждого кодировщика / декодера). . Каждый из этих наборов инициализируется случайным образом.Затем, после обучения, каждый набор используется для проецирования входных вложений (или векторов из нижних кодировщиков / декодеров) в другое подпространство представления.

С многоголовым вниманием мы поддерживаем отдельные весовые матрицы Q / K / V для каждой головы, в результате чего получаются разные матрицы Q / K / V. Как и раньше, мы умножаем X на матрицы WQ / WK / WV, чтобы получить матрицы Q / K / V.

Если мы проделаем тот же расчет самовнимания, который мы описали выше, всего восемь раз с разными весовыми матрицами, мы получим восемь разных Z-матриц

Это оставляет нам небольшую проблему.Слой прямой связи не ожидает восьми матриц — он ожидает единственную матрицу (вектор для каждого слова). Итак, нам нужен способ сжать эти восемь в единую матрицу.

Как мы это делаем? Мы объединяем матрицы, а затем умножаем их на дополнительную матрицу весов WO.

Вот и все, что нужно для многоглавого самовнимания. Я понимаю, что это довольно много матриц. Позвольте мне попытаться объединить их все в один визуальный ряд, чтобы мы могли рассматривать их в одном месте

Теперь, когда мы коснулись головок внимания, давайте вернемся к нашему предыдущему примеру, чтобы увидеть, на чем фокусируются различные головы внимания, когда мы кодируем слово «оно» в нашем примере предложения:

Когда мы кодируем слово «оно», одна голова внимания больше всего сосредотачивается на «животном», в то время как другая фокусируется на «усталом» — в некотором смысле, представление модели слова «оно» вписывается в некоторые из представлений. как «животное», так и «уставшее».

Однако, если мы добавим к изображению все внимание, интерпретировать вещи будет сложнее: